Edição 164 _ Outubro 2009

Política C&T

Educação

Trabalho integrado

Projeto mostra como a escola pública pode se transformar num espaço de reflexão

Por Fabrício MarquesColaboração

Parcerias de impacto

FAPESP celebra acordos de cooperação com conselhos de pesquisa e universidade do Reino Unido

Por Fabrício MarquesCiência

Botânica

Lá no alto da serra

Plantas raras crescem isoladas principalmente em terras altas

Por Carlos FioravantiNeurofisiologia

Efeitos da aversão

Situação que causa repulsa aumenta atenção e percepção visual

Por Ricardo ZorzettoAstronomia

Terra inóspita

O menor planeta já descoberto fora do Sistema Solar tem superfície rochosa e temperaturas extremas

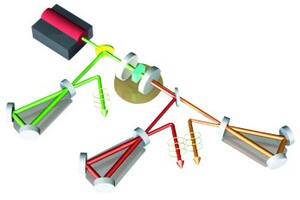

Por Ricardo ZorzettoFísica

Partículas rebeldes

Comportamento de átomos pode prejudicar o funcionamento de computador quântico

Por Ricardo ZorzettoTecnologia

Novos materiais

Ourivesaria colorida

Pó de ouro misturado a outros metais resulta em ligas de cores variadas para a fabricação de joias

Por Dinorah ErenoEngenharia de Materiais

Finas e flexíveis

Pesquisadores brasileiros criam telas multimídia com papel transparente e dobrável

Por Yuri VasconcelosEnergia

Querosene vegetal

Na Unicamp pesquisadores desenvolvem biocombustível de alta pureza para aviões

Por Evanildo da SilveiraAgricultura

Detalhes no solo

Sistema integra satélite e sensores para elaborar um mapa pormenorizado de áreas de plantio

Por Marcos de Oliveira