Instituições científicas e de ensino superior do Brasil começam a formular recomendações para o uso de inteligência artificial (IA), especialmente a generativa, no ensino, na pesquisa e na extensão. A popularização de softwares como o ChatGPT, capazes de gerar texto, imagens e dados, tem levantado dúvidas sobre limites éticos no uso dessas tecnologias, principalmente na escrita acadêmica. Professores têm procurado novas formas de avaliar trabalhos de alunos, tentando contornar os riscos de uso indevido de IA. De maneira geral, as orientações pedem que seu uso seja transparente e alertam para o perigo de ferir direitos autorais, praticar plágio, gerar desinformação e replicar vieses discriminatórios que essas ferramentas podem reproduzir.

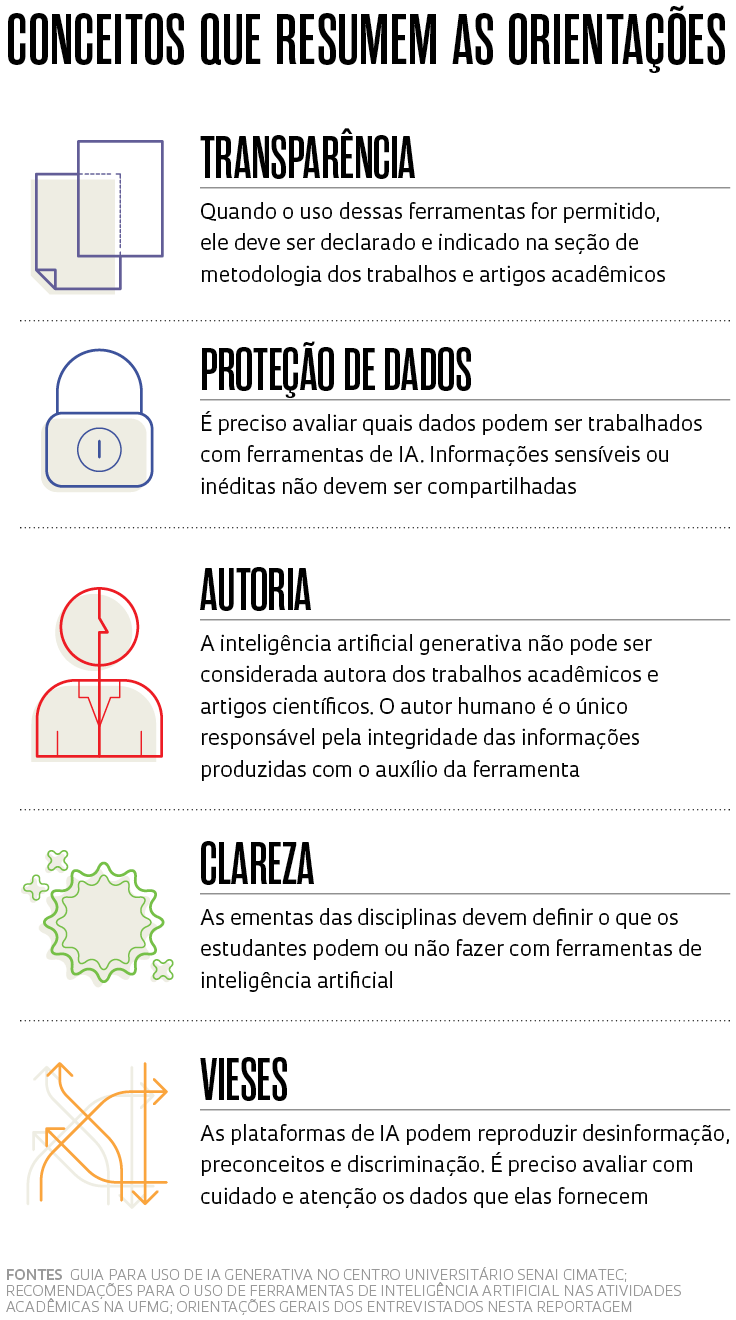

Em fevereiro, o centro universitário Senai Cimatec, na Bahia, publicou um guia para orientar sua comunidade acadêmica quanto à IA generativa. Ele segue três princípios: transparência; “centralidade na pessoa humana”, ou seja, que o controle humano seja preservado sobre as informações geradas por IA, já que ela deve ser usada de forma benéfica à sociedade; e atenção à privacidade de dados, sobretudo em atividades que envolvam contratos com empresas por meio de parcerias para desenvolvimento e transferência de tecnologias. Ocorre que as informações compartilhadas em plataformas de IA podem ser armazenadas pela ferramenta, quebrando o sigilo de dados. “Não podemos nos esquecer de que, se nós aprendemos com essas ferramentas, elas também aprendem com a gente”, ressalta a engenheira civil Tatiana Ferraz, pró-reitora administrativo-financeira do Senai Cimatec e coordenadora do guia. Uma atualização do regulamento disciplinar da instituição passou a prever punições para estudantes que quebrarem as regras.

O guia autoriza professores a usarem softwares de detecção de plágio quando julgarem necessário, embora não sejam 100% precisos ao indicar conteúdo produzido por IA. As ferramentas não podem ser citadas como coautoras de trabalhos acadêmicos, mas sua aplicação para auxiliar processos de pesquisa e ajustes de escrita acadêmica é permitida. Para isso, todos os comandos utilizados – as perguntas e direcionamentos dados à ferramenta, também chamados de prompts – e as informações originais geradas por IA devem ser descritos na metodologia do trabalho e anexados como material suplementar.

Outras instituições brasileiras seguem por esse caminho. “A universidade não deve proibir, mas criar orientações para utilização responsável dessas ferramentas”, observa o cientista da computação Virgílio Almeida, coordenador de uma comissão da Universidade Federal de Minas Gerais (UFMG), que propôs recomendações para o uso de tecnologias de IA na instituição, apresentadas à comunidade acadêmica em maio. As sugestões devem servir de base para a criação de uma política institucional com regras e normas e de um comitê de governança permanente.

Elas passam pelas áreas de ensino, pesquisa, extensão e administração e têm como princípios a transparência no uso dessas ferramentas, atenção à proteção e privacidade de dados, à desinformação e aos vieses discriminatórios que essas tecnologias podem reproduzir. “Uma das propostas é que a universidade invista em cursos de letramento em IA para professores, pesquisadores, funcionários e alunos”, explica Almeida. No ensino, uma das indicações é que as ementas das disciplinas de graduação e de pós-graduação da UFMG devem informar o que é permitido fazer com essas tecnologias. Na pesquisa, a ênfase está na transparência: é preciso detalhar como a IA foi usada no processo científico e quais vieses pode trazer a ele. A análise cuidadosa dos resultados gerados por IA, para que se evitem dados falsos, é outro ponto recomendado.

A Universidade de São Paulo (USP) publicou um dossiê da Revista USP sobre inteligência artificial na pesquisa científica em maio e tem realizado encontros e debates sobre o assunto. “A sugestão geral é estudar como incorporar esse uso no ensino e na pesquisa e verificar quais seriam suas limitações éticas e seus potenciais”, observa a advogada Cristina Godoy, da Faculdade de Direito de Ribeirão Preto (FDRP-USP), integrante de um grupo de pesquisadores que elaborou propostas para a universidade, como a necessidade de criar guias de orientação na graduação e pós-graduação. Há alertas para o cuidado com a privacidade de dados sensíveis ou inéditos de pesquisa, como teses e dissertações, e para a necessidade de buscar novas maneiras de avaliar os trabalhos em sala de aula. As recomendações foram feitas durante um evento em março de 2023 e estão sob análise de um grupo de trabalho.

O uso de IA na pesquisa não é novo. Ferramentas de aprendizado de máquina e de processamento de linguagem natural já são usadas para analisar padrões em meio a grandes volumes de dados. Mas, com o avanço das plataformas que usam IA generativa, diversas universidades dos Estados Unidos e da Europa criaram instruções sobre o assunto, que serviram de inspiração para instituições brasileiras. No Senai Cimatec, os guias das universidades de Utah, nos Estados Unidos, de julho de 2023, e de Toronto, no Canadá, ainda preliminar, serviram de norte para o grupo de trabalho, assim como o guia rápido ChatGPT e a inteligência artificial na educação superior da Organização das Nações Unidas para a Educação, a Ciência e a Cultura (Unesco), de abril de 2023.

Nesse cenário, há casos de professores que passaram a pedir aos alunos que fizessem apresentações orais, trabalhos dentro da sala de aula ou mesmo feitos à mão, no papel. Godoy, da USP, que costumava pedir trabalhos escritos sobre artigos estudados, passou a exigir que os alunos apresentassem esquemas com mapas mentais que mostrem as conexões entre os textos estudados em aula.

Em 2024, ela desenvolveu uma atividade de pesquisa no âmbito do Centro de Inteligência Artificial (C4AI) da USP, apoiado por IBM e FAPESP, com alunos de iniciação científica, mestrado e doutorado em computação, ciência política e direito em que eles precisaram desenvolver prompts no ChatGPT para realizar a análise de sentimentos – técnica que classifica opiniões como positivas, negativas ou neutras – de usuários do X (ex-Twitter) sobre IA. Os dados vão integrar um artigo em processo de escrita. Parte do trabalho será detalhar a metodologia e os prompts usados. Por não ser preciso criar um algoritmo específico para a atividade, a ferramenta acelerou o processo de análise dos dados – segundo Godoy, caso precisassem fazer tudo do zero, o trabalho levaria oito meses, mas com o ChatGPT levou dois meses.

“Algumas instituições do Poder Judiciário já avaliam usar IA para otimizar etapas de análises de processos. Por isso, negar seu uso não é uma vantagem para os alunos, que precisam estar preparados, de uma maneira crítica e responsável”, pondera a advogada. Em sua percepção, os alunos que têm melhor desempenho em redações e provas são os que desenvolvem os melhores prompts. “Para fazer boas perguntas à plataforma de IA e chegar ao resultado desejado, é preciso identificar com clareza o problema que se quer abordar”, diz Godoy.

Léo Ramos Chaves / Revista Pesquisa FAPESPExemplo de exercício que o administrador de empresas Ricardo Limongi, da UFG, faz em sala de aula para ajudar os estudantes a entender conceitos na área de estatísticaLéo Ramos Chaves / Revista Pesquisa FAPESP

O cientista da computação Rodolfo Azevedo, do Instituto de Computação da Universidade Estadual de Campinas (Unicamp), ministrou no primeiro semestre de 2024 uma disciplina-piloto de introdução à programação com assistente de código, junto ao engenheiro eletrônico Jacques Wainer, também professor da Unicamp. Os alunos, estudantes do curso de engenharia de alimentos, aprenderam a programar pela primeira vez com o ChatGPT como assistente em sala de aula, usando a linguagem Python. “O objetivo foi ensinar conceitos de programação, focando em desenvolver a habilidade de decompor um problema em etapas menores e resolvendo essas partes. Os meios sempre estão em transformação, desde os primeiros cartões perfurados”, diz Azevedo.

Em sua avaliação, usar IA generativa fez com que os alunos pudessem se preocupar com problemas mais complexos. “Se antes era preciso programar do zero, o que tomava mais tempo, agora a IA escreve os códigos com base nas instruções que o aluno fornece. O estudante consegue analisar de maneira mais profunda os erros, que sempre acontecem, e propor soluções e melhorias mais elaboradas”, afirma o cientista da computação, que ressalta que a tecnologia já está em uso por programadores de muitas empresas, que a utilizam para otimizar seus processos. Ele ainda vê outros usos no meio acadêmico. “Essas ferramentas podem diminuir a desigualdade para pesquisadores que não têm o inglês como língua nativa, já que eles podem pedir que a IA melhore as traduções de seus artigos para o idioma”, avalia.

O administrador de empresas Ricardo Limongi, da Universidade Federal de Goiás (UFG), procura ensinar aos alunos como usar essas ferramentas com uma visão crítica. “Explico que eu uso e que eles também podem usar. Isso não é trapacear”, observa. Em sala de aula, ele abre plataformas de IA e mostra aos alunos como se faz um prompt, por exemplo. Em uma das disciplinas que ministra, de estatística, Limongi costuma contar com a ajuda da IA generativa para explicar conceitos que os alunos têm dificuldade de entender, sempre supervisionando as respostas. “Saem analogias ótimas”, diz.

Autor de um artigo sobre aplicação de IA na pesquisa científica publicado em abril de 2024 na Future Studies Research Journal, Limongi tem sido convidado para proferir palestras sobre o tema em universidades. Nos encontros, ele realiza oficinas em que apresenta ferramentas de IA generativa que tem utilizado com seus alunos para otimizar processos de pesquisa.

Nas revistas científicas

Além das universidades, as maiores editoras científicas mundiais têm divulgado regras sobre IA generativa. Em um levantamento da Nature de setembro de 2023, com mais de 1.600 cientistas, quase 30% deles afirmaram ter utilizado essa tecnologia para auxiliar na redação de manuscritos e cerca de 15% para a escrita de pedidos de financiamento. Já um estudo publicado na revista British Medical Journal (BMJ) em janeiro de 2024 indicou que, entre as 100 maiores editoras de revistas científicas, 24% forneceram orientações sobre o uso de IA, e dos 100 periódicos mais bem ranqueados, 87% estabeleciam regras nesse sentido. Das editoras e periódicos com diretrizes, a inclusão de IA como autora de um artigo foi proibida em 96% e 98%, respectivamente.

O grupo Springer Nature atualiza suas regras de maneira constante e define que o uso de IA generativa deve ser documentado na seção de métodos do manuscrito. Imagens e vídeos gerados por IA são proibidos. Os revisores também não devem utilizar softwares de IA generativa na avaliação de artigos científicos, por conterem informações inéditas de pesquisa. A editora Elsevier permite que a IA seja usada para melhorar a linguagem e legibilidade do texto, “mas não para substituir tarefas autorais essenciais, como produzir insights científicos, pedagógicos ou médicos, tirar conclusões científicas ou para fornecer recomendações clínicas”.

No Brasil, a biblioteca SciELO lançou um guia de uso de ferramentas e recursos de IA em setembro de 2023. “Acompanhando as editoras internacionais, um dos principais pontos é que a IA não pode ser considerada uma autora do trabalho”, explica Abel Packer, coordenador da SciELO. O manual exige que os autores declarem quando utilizarem as ferramentas – quem esconder estará cometendo uma grave falha ética. Entretanto, o documento incentiva a aplicação da tecnologia para a preparação, redação, revisão e tradução de artigos. “Na nossa visão, daqui a cinco anos, a comunicação científica deve mudar completamente e o uso dessas ferramentas será ubíquo”, diz Packer. Para ele, essas ferramentas devem, em breve, ter um papel auxiliar nos processos de avaliação e revisão dos manuscritos submetidos aos periódicos.

A reportagem acima foi publicada com o título “Orientações a caminho” na edição impressa nº 342, de agosto de 2024.

Artigos científicos

LIMONGI, R. The use of artificial intelligence in scientific research with integrity and ethics. Future Studies Research Journal: Trends and Strategies. v. 1, n. 16. abr. 2024.

GANJAVI, C. et al. Publishers’ and journals’ instructions to authors on use of generative artificial intelligence in academic and scientific publishing: bibliometric analysis. BMJ, v. 384. 31 jan. 2024.

Republicar