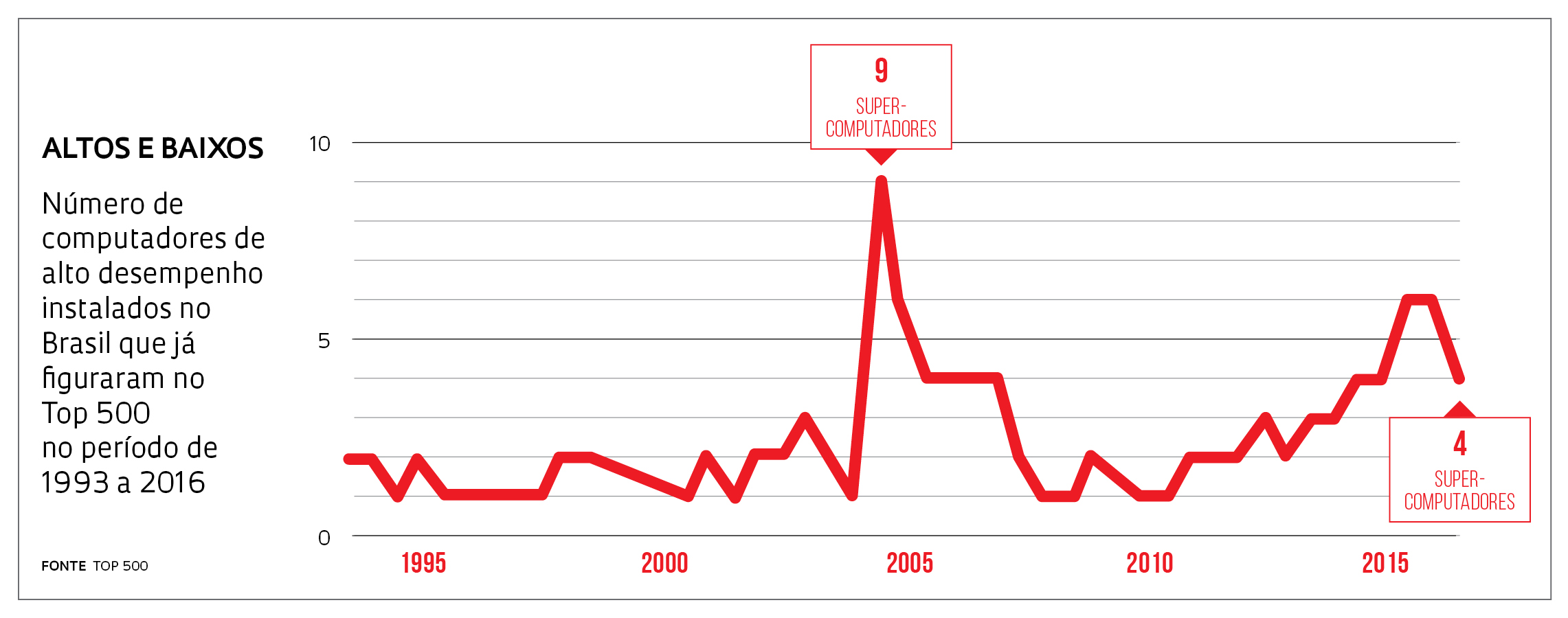

Em um intervalo de poucos meses, o Brasil perdeu sete posições no ranking das nações com os maiores parques de supercomputadores. Em novembro do ano passado, o país ocupava a 10ª colocação, com seis máquinas entre as 500 com mais alto desempenho no mundo. Em junho deste ano, caiu para o 17º lugar, com quatro computadores. O melhor momento do país foi em 2004, quando teve nove representantes na lista. Os dois supercomputadores brasileiros que deixaram o ranking pertencem à Petrobras e ao Instituto Nacional de Pesquisas Espaciais (Inpe). Ambos seguem produzindo cálculos complexos e velozes, na casa dos trilhões de operações por segundo, e são indispensáveis para simular perfurações em campos de petróleo e produzir pesquisas sobre clima e previsões meteorológicas acuradas. Mas já não figuram na relação dos 500 mais velozes porque foram superados por outros de fabricação recente. Inaugurado neste ano, o computador mais veloz do mundo, o Sunway TaihuLight, da China, é capaz de realizar 93 quatrilhões de cálculos por segundo – desempenho três vezes superior ao do 2º lugar, o também chinês Tinhae-2. O país asiático tem 168 máquinas no Top 500, que é divulgado desde 1993 pelas universidades de Mannheim, na Alemanha, e do Tennessee, nos Estados Unidos.

Em um intervalo de poucos meses, o Brasil perdeu sete posições no ranking das nações com os maiores parques de supercomputadores. Em novembro do ano passado, o país ocupava a 10ª colocação, com seis máquinas entre as 500 com mais alto desempenho no mundo. Em junho deste ano, caiu para o 17º lugar, com quatro computadores. O melhor momento do país foi em 2004, quando teve nove representantes na lista. Os dois supercomputadores brasileiros que deixaram o ranking pertencem à Petrobras e ao Instituto Nacional de Pesquisas Espaciais (Inpe). Ambos seguem produzindo cálculos complexos e velozes, na casa dos trilhões de operações por segundo, e são indispensáveis para simular perfurações em campos de petróleo e produzir pesquisas sobre clima e previsões meteorológicas acuradas. Mas já não figuram na relação dos 500 mais velozes porque foram superados por outros de fabricação recente. Inaugurado neste ano, o computador mais veloz do mundo, o Sunway TaihuLight, da China, é capaz de realizar 93 quatrilhões de cálculos por segundo – desempenho três vezes superior ao do 2º lugar, o também chinês Tinhae-2. O país asiático tem 168 máquinas no Top 500, que é divulgado desde 1993 pelas universidades de Mannheim, na Alemanha, e do Tennessee, nos Estados Unidos.

Os supercomputadores brasileiros citados no ranking foram inaugurados no ano passado. Três deles compõem o cluster Santos Dumont, em operação no Laboratório Nacional de Computação Científica (LNCC), no Rio de Janeiro, e o outro, batizado de Yemoja, foi instalado no Campus Integrado de Manufatura e Tecnologia do Serviço Nacional de Aprendizagem Industrial (Senai Cimatec), em Salvador, Bahia. “A perda de posições mostra que o Brasil atualiza seu parque de supercomputadores em um ritmo mais lento que o de outros países”, afirma Pedro Leite da Silva Dias, professor do Instituto de Astronomia, Geofísica e Ciências Atmosféricas da Universidade de São Paulo (IAG-USP), que foi diretor do LNCC entre 2007 e 2015. O laboratório é vinculado ao Ministério da Ciência, Tecnologia, Inovações e Comunicações. “Por outro lado, estivemos por um bom tempo com apenas um computador na lista, que é dinâmica e muda rapidamente. Para ficar sempre no topo, ou pelo menos não cair, é preciso investir muito na modernização do parque computacional de alto desempenho”, completa Dias. A queda do Brasil no ranking acende um sinal de alerta. “Ter domínio de tecnologias de processamento computacional é uma vantagem competitiva, pois os supercomputadores ajudam a desenvolver pesquisas na fronteira do conhecimento”, diz Augusto Gadelha, atual diretor do LNCC. “Máquinas mais potentes incentivam os pesquisadores a tentar resolver problemas mais complexos.” Na segunda metade dos anos 1990, o Brasil era o líder em número de supercomputadores entre as nações que hoje compõem o bloco dos Brics [Brasil, Índia, China, Rússia e África do Sul]. Atualmente, está à frente apenas da África do Sul. “Nos últimos anos, assistimos ao avanço da China, que superou os Estados Unidos e hoje tem o maior parque. A rivalidade entre os dois países criou uma espécie de Guerra Fria da supercomputação”, observa Dias. Há uma disputa para ver quem será o primeiro a ter um computador capaz de alcançar os exaflops, ou seja, chegar à casa de 1 quintilhão de operações matemáticas por segundo.

Além de serem uma poderosa ferramenta de pesquisa, supercomputadores dão suporte também a áreas consideradas estratégicas por muitos governos, como defesa, energia nuclear e saúde. Em 2014, o Laboratório Nacional Oak Ridge e o Laboratório Nacional Lawrence Livermore, ambos nos Estados Unidos, investiram US$ 325 milhões na aquisição de supercomputadores da IBM que hoje são usados por pesquisadores em estudos sobre mudanças climáticas, novos materiais e energias renováveis. A infraestrutura é compartilhada com órgãos de governo, como o Departamento de Energia (DOE). No caso da China, boa parte dos supercomputadores é utilizada por instituições governamentais. “Eles ajudaram em várias frentes, como no planejamento da construção de hidrelétricas”, explica Dias.

Líder na América Latina

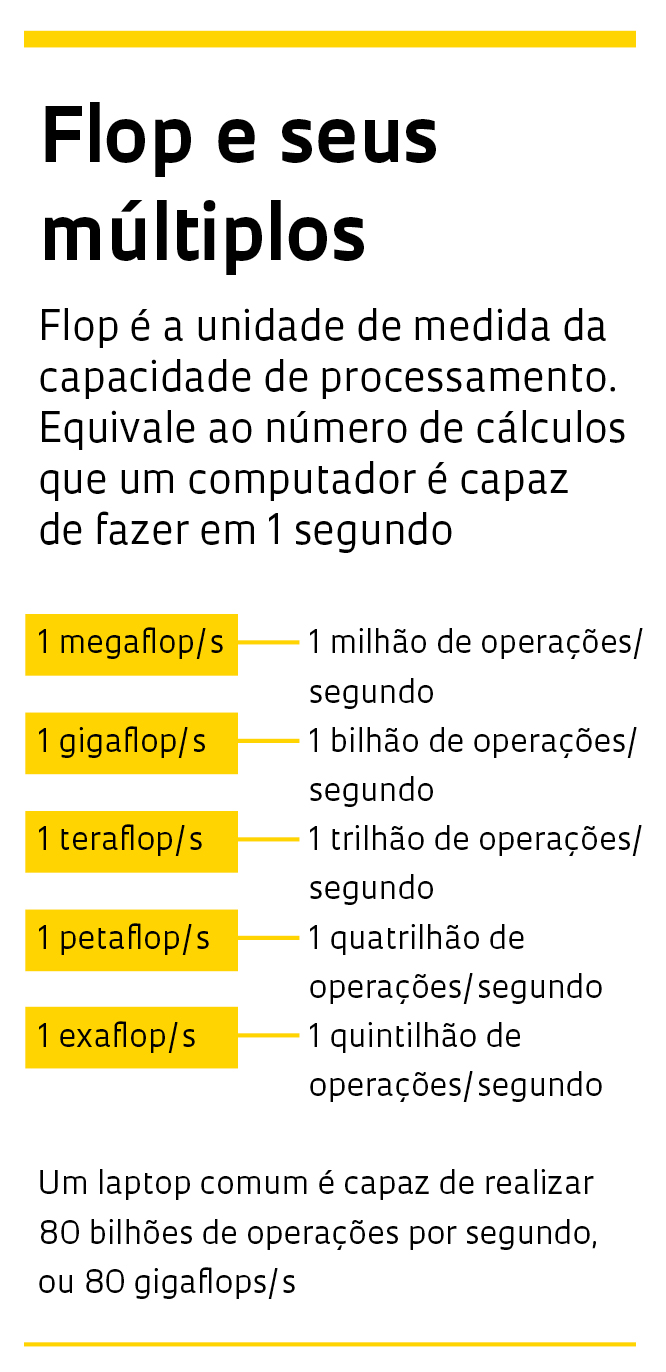

Único país na América Latina a figurar no ranking Top 500, o Brasil abriga apenas 0,8% dos 500 supercomputadores do mundo, um percentual inferior à contribuição do país para a ciência mundial, que é de pouco mais de 2% dos artigos publicados em revistas indexadas. A computação de alto desempenho é relativamente nova no país: a primeira aquisição remonta ao final dos anos 1980. Na época, a Financiadora de Estudos e Projetos (Finep) lançou um programa para promover a compra de supercomputadores em universidades e instituições de pesquisa. A primeira beneficiada foi a Universidade Federal do Rio Grande do Sul (UFRGS). Em 1994, o Centro de Previsão de Tempo e Estudos Climáticos (CPTEC) do Inpe adquiriu seu primeiro supercomputador, um NEC Sx-3 de 3,2 gigaflops de capacidade. “A previsão do tempo exige a resolução de equações complexas em poucas horas. E isso só se faz com um processamento extremamente veloz”, explica Luiz Flávio Rodrigues, chefe do serviço de supercomputação e suporte do CPTEC-Inpe.

Para dar conta de tais exigências, os supercomputadores devem ser substituídos a cada quatro ou cinco anos. Desde 1994, o Inpe já teve cinco equipamentos. O mais recente é um Cray XT-6, batizado de Tupã (trovão, em guarani), adquirido em 2010 por R$ 50 milhões – R$ 15 milhões da FAPESP e R$ 35 milhões do governo federal. O supercomputador tem 256 teraflops de capacidade. “Com a crise, não há perspectiva de substituí-lo no curto prazo. Como o computador já está entrando em fim de vida útil, atualizaremos alguns componentes, o que deve mantê-lo em operação por mais dois anos”, conta Rodrigues.

O Tupã se divide em duas frentes de trabalho: 50% de seu tempo de uso é dedicado ao trabalho operacional do CPTEC, que inclui a previsão meteorológica, e os outros 50% à pesquisa científica. Uma das aplicações do Tupã é o processamento do Modelo Brasileiro do Sistema Terrestre (Brazilian Earth System Model – Besm), um dos pilares do Programa FAPESP de Pesquisa em Mudanças Climáticas Globais, lançado em 2008. Sob coordenação do Inpe, o Besm foi desenvolvido com base em parâmetros climáticos da América do Sul, incorporando processos regionais de formação de nuvens, além do conhecimento criado no país referente à influência da Floresta Amazônica sobre o clima global. Em 2012, o modelo brasileiro passou a contribuir com o Painel Intergovernamental sobre Mudanças Climáticas (IPCC, na sigla em inglês).

paulo faria O cluster computacional Santos Dumont está instalado na sede do LNCC em Petrópolis, no Rio de Janeiropaulo faria

A indústria de petróleo e gás também utiliza de modo intensivo os supercomputadores para calcular o potencial de reservatórios, reduzir o risco de vazamentos, entre outras aplicações. Os dois principais computadores da Petrobras, o Grifo04 e o Grifo06, são utilizados para gerar mapas em alta resolução do subsolo, obtidos por meio da emissão de ondas sonoras. A empresa também utiliza a capacidade de processamento de instituições parceiras, como o Instituto Alberto Luiz Coimbra de Pós-graduação e Pesquisa em Engenharia da Universidade Federal do Rio de Janeiro (Coppe-UFRJ). Muitos projetos da Petrobras são liderados por pesquisadores do Núcleo Avançado de Computação de Alto Desempenho (Nacad) do Coppe e do Centro de Pesquisa e Desenvolvimento (Cenpes) da Petrobras. Em julho, o Coppe inaugurou o Lobo Carneiro, supercomputador fabricado pela norte-americana SGI, com capacidade de 226 teraflops – pode executar 226 trilhões de operações matemáticas por segundo. Assim como o computador Santos Dumont do LNCC, a máquina também atenderá ao projeto High Performance Computing for Energy (HPC4E), que reúne instituições de pesquisa e empresas do Brasil e da União Europeia com o objetivo de melhorar a eficiência do setor energético. “Além de clientes na área de óleo e gás, como a Petrobras, muitos de nossos usuários atuam na área de engenharia, com destaque para a investigação em diferentes formas de energia, como a solar e a eólica”, explica Guilherme Horta Travassos, professor do Programa de Sistemas e Computação da Coppe-UFRJ e presidente da comissão de administração do Nacad. O Lobo Carneiro custou US$ 4,2 milhões. Os recursos vieram de fontes como a UFRJ, a Agência Nacional de Petróleo (ANP), entre outros.

Reforço baiano

Outra novidade para o segmento de óleo e gás no país entrou em operação recentemente em Salvador, na Bahia. Trata-se do Yemoja (Yemanjá, na língua iorubá), fabricado pela SGI. Um dos computadores mais rápidos instalados na América Latina, ele foi adquirido em 2015 graças a uma parceria entre o Senai da Bahia e a BG Brasil (Shell). Há projetos em andamento voltados para a inovação na área de óleo e gás, mas o Senai Cimatec não divulga informações sobre eles. Com 405 teraflops de capacidade de processamento, o Yemoja ocupava a 95ª posição no Top 500 no início de sua operação e hoje é o 323º colocado no ranking. “Será implantado um segundo supercomputador voltado para estudos em biomedicina, robótica, processamento de imagens e energias alternativas”, informa o engenheiro João Marcelo Silva Souza, líder da área de processamento de alto desempenho do Senai Cimatec.

Outro investimento recente em computação de alto desempenho beneficiou o Centro de Ciências Matemáticas Aplicadas à Indústria (CeMEAI), um dos Centros de Pesquisa, Inovação e Difusão (Cepid) apoiados pela FAPESP, que inaugurou em julho de 2015 o cluster computacional Euler, no campus da USP em São Carlos. Adquirido por R$ 4,5 milhões, o sistema é composto por 104 computadores ligados em rede, com capacidade de fazer 47 trilhões de operações por segundo. “É um dos computadores mais rápidos já instalados em universidades de São Paulo”, afirma José Alberto Cuminato, professor do Instituto de Ciências Matemáticas e de Computação (ICMC) da USP e diretor do CeMEAI.

Batizado em homenagem ao matemático e físico suíço Leonhard Paul Euler (1707-1783), o sistema é utilizado em simulações de escoamento de fluidos, com aplicação em engenharia de petróleo e aeroespacial, de redes complexas, como a propagação de epidemias, e de nanoestruturas, entre outros. Por se tratar de um equipamento multiusuário financiado pela FAPESP, é franqueado a outras instituições do estado de São Paulo. Alguns dos principais usuários do Euler são pesquisadores do Instituto Tecnológico de Aeronáutica (ITA), em São José dos Campos, da Universidade Federal de São Carlos (UFSCar), do Laboratório Nacional de Luz Síncrotron (LNLS) e da Universidade do Texas, nos Estados Unidos.

Batizado em homenagem ao matemático e físico suíço Leonhard Paul Euler (1707-1783), o sistema é utilizado em simulações de escoamento de fluidos, com aplicação em engenharia de petróleo e aeroespacial, de redes complexas, como a propagação de epidemias, e de nanoestruturas, entre outros. Por se tratar de um equipamento multiusuário financiado pela FAPESP, é franqueado a outras instituições do estado de São Paulo. Alguns dos principais usuários do Euler são pesquisadores do Instituto Tecnológico de Aeronáutica (ITA), em São José dos Campos, da Universidade Federal de São Carlos (UFSCar), do Laboratório Nacional de Luz Síncrotron (LNLS) e da Universidade do Texas, nos Estados Unidos.

Um grupo de pesquisadores do ICMC-USP utiliza o cluster, em parceria com a Petrobras, para simulações de extração, refino e combustão de petróleo. Em março de 2017 o Euler deverá ser atualizado pela primeira vez, ao custo de R$ 2 milhões. “Não basta ter recursos apenas para a compra de um supercomputador. A operação desse tipo de equipamento implica gastos com manutenção e energia. A instituição precisa prever tudo isso no orçamento”, avalia Cuminato, lembrando que a conta de energia do Euler é paga pela USP.

Para aumentar sua capacidade de processamento, a USP firmou em 2012 um acordo com a Universidade Rice, nos Estados Unidos, que dispõe de um computador doado pela IBM, o Blue Gene/Q, com capacidade de 189 teraflops. “A USP contrata os serviços anualmente e utiliza aproximademente 30% da capacidade do supercomputador em estudos em áreas como engenharia, física, astronomia e ciências atmosféricas”, diz João Eduardo Ferreira, superintendente de Tecnologia da Informação da USP. Cerca de 41% da cota da USP no Blue Gene é utilizada por pesquisadores do Instituto de Física; 18%, da Escola Politécnica (Poli); e 17%, do Instituto de Astronomia e Geofísica (IAG). No total, a USP desembolsa cerca de US$ 500 mil por ano para ter acesso ao Blue Gene/Q. Dois clusters computacionais da USP, batizados de Águia (45 teraflops) e Lince (70 teraflops), complementam o trabalho da máquina estadunidense. De acordo com Ferreira, a parceria da USP com a Universidade Rice levou em consideração o fator da sustentabilidade do supercomputador. O Blue Gene/Q é uma das máquinas mais econômicas do mundo e figura no Top Green 500, uma outra lista que divulga as máquinas com maior eficiência energética.

Custos elevados

Custos elevados

Além de custar caro e de ter uma vida útil relativamente curta, um supercomputador tem manutenção dispendiosa. Para Travassos, da UFRJ, os custos com energia e manutenção foram fatores importantes na decisão da compra do supercomputador Lobo Carneiro. “Mesmo sendo muito eficiente, a conta de luz pode chegar a R$ 60 mil mensais, com a utilização plena do sistema”, afirma. A preocupação com computadores econômicos é global. “Supercomputadores acarretam altos gastos com manutenção e conta de luz”, diz Pedro Dias, da USP. O Santos Dumont, do LNCC, só entrou em plena operação em junho. Entre janeiro e maio, funcionou apenas quatro horas por dia e não esteve disponível à comunidade científica. O motivo foi a falta de recursos. “O LNCC teve redução do orçamento entre 2015 e 2016. Em junho, isso foi resolvido e hoje o Santos Dumont atende a 42 projetos, em temas como nanotecnologia, energias renováveis, engenharia civil, desenvolvimento de vacinas contra dengue e zika, produção de softwares, astronomia, entre outros”, diz Gadelha. A máquina consome 0,8 megawatt (MW) e o valor da conta de luz é de R$ 350 mil a R$ 400 mil por mês. O Santos Dumont e o Lobo Carneiro são as únicas máquinas brasileiras que figuram este ano na Green 500.

Adquirido por aproximadamente R$ 45 milhões da empresa francesa Atos/Bull, o Santos Dumont é composto por três sistemas computacionais distintos com capacidade de alcançar 1,1 petaflop. Isso significa que ele é capaz de realizar 1 quatrilhão de operações matemáticas por segundo – aproximadamente 1 milhão de vezes mais rápido que um notebook comum. É peça central do Sistema Nacional de Processamento de Alto Desempenho (Sinapad), rede formada por nove Centros Nacionais de Processamento de Alto Desempenho (Cenapads), operados por universidades e instituições de pesquisa. O Nacad, do Coppe, é um desses centros que estão interligados e podem ser utilizados remotamente por pesquisadores de todo o país. Criado em 1994, o Cenapad de São Paulo está localizado na Universidade Estadual de Campinas (Unicamp) e já foi utilizado por pesquisadores de 18 estados brasileiros, sendo 36% de São Paulo, 25% do Rio Grande do Sul e 13% de Minas Gerais. “A maior parte dos usuários atua nas áreas de matemática, física, química, geociências e biologia”, diz José Augusto Chinellato, professor no Instituto de Física Gleb Wataghin da Unicamp e coordenador do Cenapad-SP. No total, estão em andamento 172 projetos executados por 502 pesquisadores de instituições de todo o Brasil. “O Sinapad consolidou-se como uma rede de computação de alto desempenho voltada para as universidades e instituições de pesquisa”, explica Chinellato.

Pedro Dias observa que o Brasil privilegiou a pulverização dos recursos para a computação de alto desempenho. “Optou-se pela compra de um número grande de pequenas máquinas”, explica. Nos Estados Unidos, o modelo é o oposto: há grandes centros computacionais espalhados pelo país, que atendem às demandas da pesquisa e da indústria. Segundo ele, a falta de mais máquinas robustas explica por que muitos pesquisadores brasileiros recorrem a computadores instalados no exterior, por meio de colaborações científicas, ou contratando serviços de processamento de empresas como Google e Amazon. De acordo com Gadelha, do LNCC, o modelo adotado no Brasil é herança do final dos anos 1980, época em que não havia tecnologia no país capaz de garantir que pesquisadores em regiões distantes pudessem utilizar remotamente um supercomputador instalado no Sudeste. “Com isso, instituições de vários estados reivindicavam recursos para terem seus próprios computadores de alto desempenho”, explica.

Republicar