Cássia Roriz“Tenho medo de que este manuscrito possa contribuir não tanto para o avanço do campo do conhecimento, mas para o seu declínio.”

Cássia Roriz“Tenho medo de que este manuscrito possa contribuir não tanto para o avanço do campo do conhecimento, mas para o seu declínio.”

“Você teve uma convulsão quando escrevia essa frase? Porque isso aconteceu comigo enquanto lia.”

“Este é um artigo lutando para não morrer.”

Os comentários cáusticos e grosseiros acima, que lembram insultos publicados em redes sociais, foram extraídos de pareceres enviados a pesquisadores depois que eles submeteram artigos para a avaliação de revistas ou congressos científicos. A expectativa dos autores era de que os trabalhos recebessem críticas construtivas, que permitissem aperfeiçoar pontos fracos e apontar novos caminhos. Afinal, os revisores são seus pares, cientistas atuando no mesmo campo do conhecimento, que cederam seu tempo de forma voluntária para ler versões preliminares de papers de colegas. Em vez de ajudar, contudo, esses pareceristas impuseram uma experiência traumática, que pode ser particularmente assustadora para jovens autores tentando se situar na carreira acadêmica.

Mas, afinal, as frases mal-educadas acima não foram escritas em vão. Compiladas em quatro bancos de dados abertos por cientistas da computação do Instituto Indiano de Tecnologia, em Patna, elas integram um conjunto de 2.716 frases proferidas em processos de revisão por pares (algumas mal-humoradas, outras polidas ou neutras). Foram utilizadas para criar um algoritmo, por enquanto um protótipo, que, se avançar, poderá ser útil para editores e revisores que desejam analisar o tom e a qualidade de suas avaliações em língua inglesa – e modificá-las, se for o caso. O trabalho é parte do doutorado do cientista da computação Prabhat Kumar Bharti e foi publicado em fevereiro na revista Scientometrics.

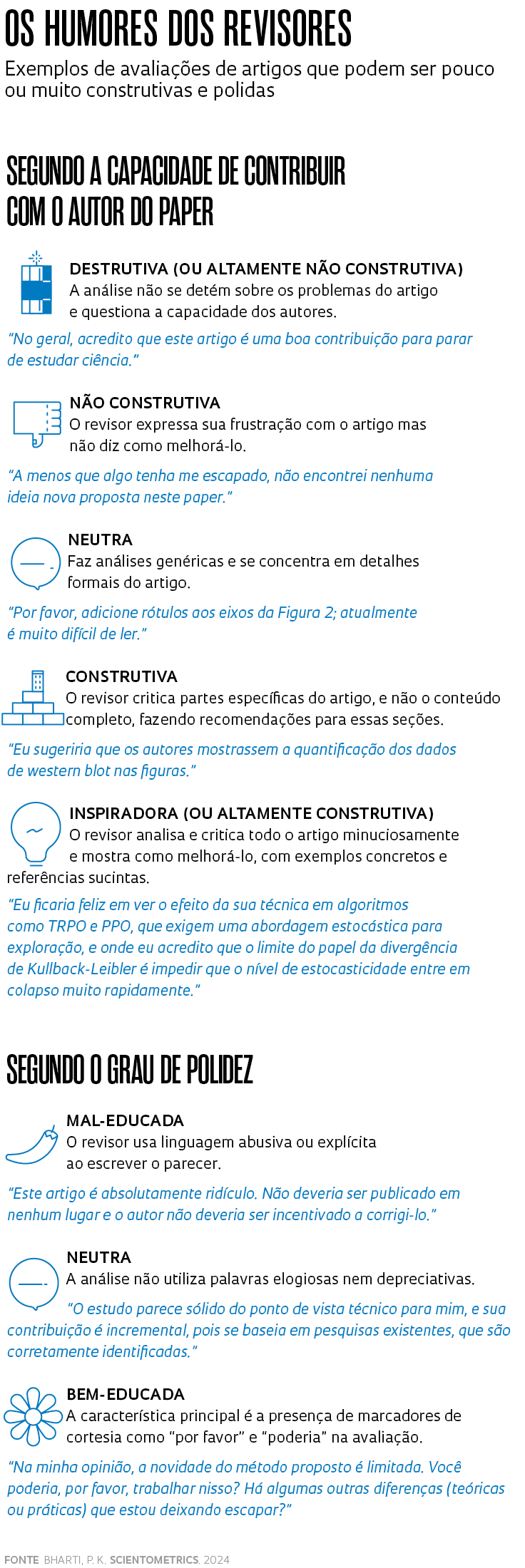

Para treinar a ferramenta, os pesquisadores indianos usaram técnicas de linguística computacional e estabeleceram duas categorias – construtividade e polidez (ver quadro abaixo) – nas quais um parecer pode ser classificado. Em uma primeira etapa, as frases foram analisadas por quatro anotadores humanos. Eles chegaram a um consenso de 88,27% ao classificar os níveis de construtividade e de 83,49% para os de polidez. O modelo computacional, depois de treinado, coincidiu com a classificação dos humanos em 87,4% das frases. O estudo observou que, em geral, quanto mais construtivo é o comentário, mais educado ele também costuma ser.

Não é novidade que grandes bases de dados científicos sejam utilizadas para desenvolver e refinar algoritmos e ferramentas – no Brasil, informações da plataforma de currículos Lattes analisadas computacionalmente vêm sendo usadas para ampliar a compreensão sobre a atividade científica no país e apontar tendências (ver Pesquisa FAPESP nº 233). Bharti explicou em seu perfil do LinkedIn que o propósito da linha de investigação é justamente extrair novos conhecimentos de uma vasta quantidade de conteúdo acadêmico. Ele e seus colaboradores destacam o potencial do modelo que desenvolveram em um sistema de comunicação científica que reúne mais de 70 mil revistas com artigos revisados por pares – são cerca de 2 milhões de manuscritos analisados a cada ano. Mais do que facilitar o trabalho dos cientistas avaliadores, um dos objetivos do estudo, segundo os autores, é alertar para o estrago causado pelos julgamentos destrutivos. “Alguns revisores têm demonstrado comportamento não profissional, fazendo comentários depreciativos sobre gênero, raça, etnia e país de origem do autor”, escreveram.

O cientista da computação Jesús Mena-Chalco, da Universidade Federal do ABC (UFABC), observa que a criação de ferramentas como a proposta pelo grupo da Índia pode ser útil como um primeiro filtro quando editores têm um grande volume de pareceres para avaliar. Ele conta que já foi vítima de um comentário que em tom grosseiro exigiu um certificado profissional de revisão da língua inglesa. “Reconheci a necessidade de melhorar o trabalho, mas a sugestão poderia ter sido dita de outra forma. Há maneiras de pedir: algumas vão nos encorajar e outras vão fazer o oposto”, comenta.

Para a linguista Maria José Bocorny Finatto, da Universidade Federal do Rio Grande do Sul (UFRGS) e especialista em linguística computacional, a proposta dos indianos joga luz sobre um problema crucial da avaliação por pares. “Esse tema precisa ser debatido em diversos ambientes, das revistas às agências de fomento”, diz ela, que também já recebeu um parecer impróprio e indelicado. “A mensagem era desagradável e me atacava como mulher pesquisadora”, recorda-se.

O tamanho do problema já foi investigado em outros estudos. Um artigo publicado em 2019 mostrou que 58% dos 1.106 pesquisadores de 46 países afirmaram ter recebido ao menos uma revisão não profissional de periódicos. Alguns dos participantes, todos eles das áreas de ciência, tecnologia, matemática e engenharia (Stem), compartilharam trechos dessas avaliações, tais como “Fulano tentou isso nos anos 1990 e falhou, e ele era mais criativo do que você”; “Este artigo é, simplesmente, esterco”; “A condição do autor como uma pessoa trans distorceu sua visão sobre sexo além da realidade biológica”. Esse estudo de 2019 dimensionou a percepção dos pesquisadores sobre os impactos desses comentários em três aspectos: a aptidão científica (confiança como cientista), a produtividade (publicações por ano) e o progresso na carreira (habilidade de avançar dentro do campo). Os resultados indicaram que homens brancos tinham mais chances de dizer que o parecer não os afetava do que homens negros, mulheres e pessoas não binárias brancas e negras. Ou seja, os autores concluíram que pesquisadores do sexo feminino e de grupos minoritários parecem se sentir mais abalados com esses pareceres grosseiros.

Em busca de modelos construtivos

É certo que a maioria das revistas científicas tem diretrizes para orientar a avaliação por pares, mas elas não garantem que o resultado será construtivo e profissional, reflete a linguista Márcia Sipavicius Seide, da Universidade Estadual do Oeste do Paraná (Unioeste). Desde 2020 ela coordena clubes de escrita e cursos de formação de editores como atividade de extensão da universidade e, por vezes, acompanha os pareceres que os participantes recebem de artigos submetidos. “Alguns comentários são rudes e não apontam caminhos”, diz ela, que é editora da revista Onomástica desde América Latina. “Se o parecer não aponta o que há de errado no trabalho e apenas o recusa, o autor não saberá por onde ir e isso é um prejuízo para a ciência como um todo.”

Essa percepção a motivou a criar modelos para avaliar a qualidade de pareceres científicos baseados em rubricas, conjuntos de critérios usados para medir o desempenho de um texto escrito por meio de pontuações, como nas redações de vestibulares. O objetivo é que eles sejam pedagógicos, educados, justificados e apontem caminhos para a pesquisa, em qualquer área do conhecimento. Seide propôs três modelos: para aprovação condicional de artigo, em que é preciso fazer ajustes; para reprovação, quando o paper não é aceito; e para aprovação direta, sem ajustes. Cada um tem quatro critérios e cinco níveis, e somam entre 10 e 20 pontos – quanto mais pontos, melhor é a qualidade da análise. Eles foram descritos em um artigo publicado em julho de 2023 na Revista Meta: Avaliação.

No aceite condicional, um dos critérios para que um parecer seja bom leva em conta se o avaliador dialoga com o autor, se faz perguntas e explica o que pode ser feito para melhorar o texto. “Já o texto de reprovação precisa ser polido, educado e não desqualificar quem escreveu o manuscrito. E o de aprovação direta soma mais pontos se justificar o elogio, informando por que o trabalho foi considerado bom”, explica. Para ela, como a avaliação de um artigo é um processo subjetivo, as rubricas podem deixá-lo mais transparente. Desde 2023 ela tem usado a metodologia para avaliar os comentários dos revisores da revista Onomástica. “Sempre confiro se a avaliação, quando aponta falhas, traz sugestões visando a resolução do que foi apontado como ponto fraco do artigo. Quero que o autor se sinta motivado a continuar escrevendo.”

Para minimizar esses problemas, há publicações que procuram destacar o trabalho dos bons avaliadores. Desde 2008, a American Physical Society (APS) reconhece cerca de 150 pareceristas “que têm sido excepcionalmente úteis na análise de manuscritos para publicação nos periódicos da APS”, segundo o site da instituição, que tem uma base de 91.600 revisores ativos. Em 2024, entre os 156 pesquisadores de 58 países destacados como Outstanding referees está o físico Paulo Campos, da Universidade Federal de Pernambuco (UFPE), único brasileiro na lista deste ano. Para ele, o caminho da crítica construtiva é apontar direcionamentos para que o artigo seja aprimorado. “Se ele tem potencial para a aprovação, é preciso indicar direções e lacunas. Se for uma negativa, é preciso sinalizar os problemas”, observa Campos, que é parecerista de periódicos da APS desde 2001. Ele vê o papel do editor científico como fundamental para filtrar comentários agressivos e pedir complementos para aqueles que não são construtivos.

O editor de periódicos na área de odontologia Sigmar de Mello Rode explica que, muitas vezes, é preciso reformular os pareceres ou mesmo pedir mais esclarecimentos aos avaliadores que não embasam adequadamente suas sugestões. Rode, pesquisador da Universidade Estadual Paulista (Unesp), é presidente da Associação Brasileira de Editores Científicos (Abec-Brasil), que criou um curso para avaliador de artigo científico. A iniciativa trabalha o passo a passo do que é preciso observar para fazer uma análise crítica e correta. “Tivemos mais de 550 inscritos em dois anos de curso e percebemos que existe a necessidade de querer saber como fazer, já que muitas vezes as orientações aos avaliadores das revistas não são completas”, diz Rode.

“Ainda discutimos pouco sobre a escuridão do processo de revisão por pares, ao qual, muitas vezes, os autores não têm acesso”, comenta o especialista em tecnologia e mídias digitais Alex Mendonça, coordenador do servidor SciELO Preprints. Segundo ele, é recorrente ouvir de editores de periódicos abrigados na biblioteca SciELO problemas com avaliações destrutivas ou sucintas. “Não há uma bala de prata para lidar com essa situação, mas temos endossado a migração para a ciência aberta incluindo a revisão por pares. À medida que pareceres se tornarem públicos, os avaliadores pensarão mais antes de tecer comentários rudes e preconceituosos.” No Brasil, ele destaca o exemplo da Bakhtiniana: Revista de Estudos do Discurso, que começou a anexar ao conteúdo dos artigos o julgamento dos revisores e a mostrar a identidade deles. Eventualmente, o comentário pode receber um DOI (Digital Object Identifier), identificador único de documentos digitais. “Dessa forma, pode ser incluído no currículo do parecerista, valorizando o seu trabalho e estimulando a fazer uma avaliação construtiva”, sugere Mendonça.