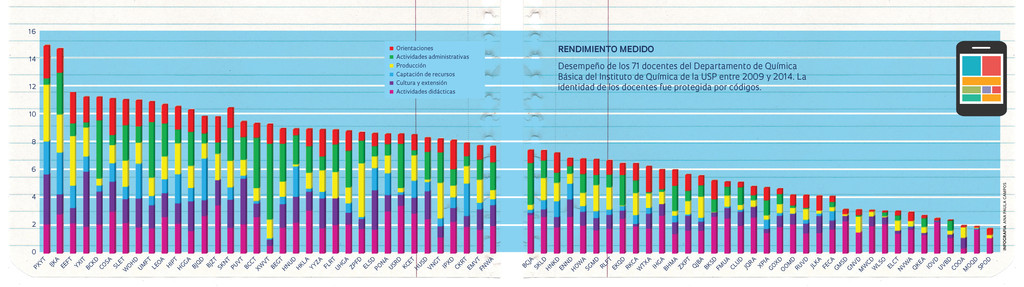

Más de 70 docentes de uno de los departamentos del Instituto de Química de la Universidad de São Paulo (IQ-USP) se sometieron recientemente a un proceso de evaluación basado en criterios tales como la producción científica, la capacidad individual de captar recursos para investigación, las tutorías de alumnos, supervisiones de posdoctorados y participaciones en tribunales de tesis y tesinas, aparte de actividades didácticas, administrativas, de cultura y de extensión en las cuales participaron durante los últimos cinco años. El resultado de esta iniciativa es una especie de ranking (véase el gráfico), en el cual dichos docentes, todos vinculados al Departamento de Química Básica del instituto, son identificados únicamente mediante códigos. Sus nombres no se divulgan para el público externo, aunque dentro da institución, la posición de todos es más o menos conocida. Durante los últimos 10 años, esta evaluación se realizó cuatro veces. En la más reciente, que posee datos de 2009 a 2014, a los nueve últimos docentes de la lista, aquéllos que obtuvieron las peores puntuaciones, se los invitó a participar en reuniones con el jefe del departamento, el profesor Mauro Bertotti. Éstos obtuvieron un resultado general de alrededor de dos puntos. El promedio del instituto fue de poco más de seis puntos, y el primero de la lista superó los 15 puntos (véase el gráfico). “Reiteramos que no se trataba de castigar a nadie y que el objetivo de la reunión consistía en saber de qué manera el departamento podría ayudarlos a mejorar su desempeño”, comenta Bertotti, quien dividió la tarea en dos reuniones, una con cuatro profesores y otra con los cinco restantes.

Aunque algunos de los docentes han formulado algunas salvedades a los criterios de la evaluación, la mayoría procuró justificar sus malos indicadores. Según Bertotti, un profesor argumentó que se le hacía difícil reclutar alumnos para trabajar en su laboratorio porque su área es poco atractiva para los jóvenes investigadores. “Nos dispusimos a ayudarlo a reunir estudiantes y le sugerimos que se uniese a otros grupos para no trabajar solo”, comenta el jefe del departamento. En tanto, los de mayor antigüedad se quejaron de la dificultad para competir con los más jóvenes, tenidos como agresivos en la búsqueda de productividad científica y recursos para investigación. “La queja señala que las reglas del juego cambiaron y los más jóvenes llevan ventaja porque dominan mejor ese nuevo ambiente”, afirma Bertotti, recordando que, para algunos pocos profesores de la generación más antigua del Departamento de Química Básica, la tarea de publicar artículos en revistas de prestigio a menudo era tenida como menos prioritaria que garantizar una formación de excelencia para los alumnos.

La experiencia, por ahora, ha generado pocos efectos concretos. Un ejemplo: uno de los docentes con evaluación desfavorable, quien admitió que dejó de hacer investigación, aceptó dejar su espacio en el laboratorio cuando surgió una discusión sobre la reasignación de instalaciones de investigación en el Instituto de Química. Pero sería parcial medir el alcance de la evaluación sólo por los resultados palpables, ya que, desde el comienzo, se estableció que nadie sería premiado o castigado. La iniciativa tiene relevancia porque su metodología se construyó y se negoció durante los últimos 10 años con la participación de los propios docentes, en el marco de un esfuerzo todavía poco común en la universidad brasileña tendiente a mejorar el desempeño del grupo. “Es un instrumento de autorregulación, en el cual los docentes se posicionan en relación con sus pares”, dice Bertotti. “Se trata de crear parámetros de evaluación de la actividad docente, con pesos ampliamente discutidos y definidos por la comunidad y que sean compatibles con la misión institucional, con el objetivo de sistematizar información, producir diagnósticos y valorar recursos humanos y económicos. La sociedad sostiene a la universidad pública y le cabe a ésta demostrar que las inversiones están gestionándose de manera responsable”, destaca.

Para Guilherme Andrade Marson, docente del IQ-USP y uno de los miembros de la Comisión de Evaluación del Desempeño Docente, el debate de los criterios obligó a los miembros del departamento a reflexionar sobre la naturaleza de su trabajo y sobre a qué consideran un estándar de excelencia. “La existencia del proceso de evaluación constituye un gran logro. Este instrumento muestra aquello que cada docente hace mejor y se lo pensó para mejorar la calidad de lo que hacemos, no para promover una caza de brujas”, pondera. El esfuerzo fue colectivo, pero quedó lejos de ser consensual. “La discusión en el consejo del departamento con respecto a los criterios quedó definida mediante el voto”, recuerda Bertotti, en referencia a la falta de entendimiento sobre el uso de indicadores tales como el factor de impacto de publicaciones y la evaluación de las carreras a cargo de los alumnos. “Lo importante es que prevaleció la idea de que la evaluación es importante”. Otro efecto que ha de considerarse es el impacto que causa en el ánimo de los investigadores más jóvenes. “Es un estímulo trabajar en un departamento que valora el mérito”, dice Pedro Cury Camargo, de 33 años, docente del IQ-USP desde 2011.

Para Guilherme Andrade Marson, docente del IQ-USP y uno de los miembros de la Comisión de Evaluación del Desempeño Docente, el debate de los criterios obligó a los miembros del departamento a reflexionar sobre la naturaleza de su trabajo y sobre a qué consideran un estándar de excelencia. “La existencia del proceso de evaluación constituye un gran logro. Este instrumento muestra aquello que cada docente hace mejor y se lo pensó para mejorar la calidad de lo que hacemos, no para promover una caza de brujas”, pondera. El esfuerzo fue colectivo, pero quedó lejos de ser consensual. “La discusión en el consejo del departamento con respecto a los criterios quedó definida mediante el voto”, recuerda Bertotti, en referencia a la falta de entendimiento sobre el uso de indicadores tales como el factor de impacto de publicaciones y la evaluación de las carreras a cargo de los alumnos. “Lo importante es que prevaleció la idea de que la evaluación es importante”. Otro efecto que ha de considerarse es el impacto que causa en el ánimo de los investigadores más jóvenes. “Es un estímulo trabajar en un departamento que valora el mérito”, dice Pedro Cury Camargo, de 33 años, docente del IQ-USP desde 2011.

La construcción del proceso de evaluación se remonta al comienzo de los años 2000, cuando Henrique Eisi Toma era jefe del Departamento de Química Básica y divulgaba en el internet el número de publicaciones indexadas de cada docente y otras informaciones. “Había un malestar con relación al desempeño del departamento medido de acuerdo con el conteo de publicaciones de la forma divulgada en los anuarios de la USP, que indicaba performance superior del promedio de los docentes de otra unidad similar”, recuerda el profesor Ivano Gebhardt Rolf Gutz, quien era subjefe del departamento durante ese período. “Era una época en la cual la Plataforma Lattes estaba poniéndose en marcha y había dificultades para reunir información referente a la producción y demás actividades de cada uno”. Se intentó integrar el recabado de datos de la secretaría de posgrado, aprovechada en los informes para Capes, con la de la biblioteca del Conjunto de Química y la del departamento, y se creó incluso una dirección de e-mail a la cual los investigadores deberían enviar la información, pero la estrategia no prosperó. “Observábamos una heterogeneidad en el departamento, con algunos profesores dedicándose más a la enseñanza que a la investigación”, recuerda Gutz.

La primera versión

En 2004, Ivano Gutz se hizo cargo de la jefatura del Departamento de Química Fundamental y decidió implementar lo que sería la primera versión del proceso de evaluación con un conjunto abarcador de indicadores, ya contemplando las actuales categorías de desempeño (véase el recuadro). La idea era asignar puntos a todo tipo de actividad realizada por los docentes y arbitrar un modo de compilar los números, de modo tal que los profesores fuesen reconocidos aun cuando no tuviesen una gran performance en investigación. Los que dictasen buenas clases, participasen activamente en comisiones y dirigiesen alumnos de grado y posgrado o se destacasen en sus actividades de extensión también sería valorados. “En esa época, arreglamos que los datos no se emplearían para tomar medidas drásticas. Hubo muchos cuestionamientos sobre la ponderación de los indicadores, pero nadie se opuso a que se reuniese la información”, recuerda Gutz.

Los puntos más controvertidos se suavizaron. En lugar de utilizar el factor de impacto de revistas científicas como peso para evaluar publicaciones de cada docente, se adoptó la raíz cuadrada del factor de impacto. El objetivo era evitar abrir un foso entre la puntuación de los que lograron publicar en periódicos de alto impacto y el de los que divulgaron sus trabajos en revistas de menor prestigio. Para publicaciones en revistas de enseñanza o educación, que suelen ser menos citadas, se recurría a la clasificación del periódico en el sistema Qualis de la Capes en reemplazo del índice de impacto. El resultado de la cuenta también debía dividirse por la raíz cuadrada de la cantidad de autores del artículo perteneciente al departamento, y le cabía a cada uno de ellos un quiñón equivalente.

Las planillas tenían en cuenta indicadores del trienio anterior (actualmente la información contempla cinco años de trabajo de cada docente). La puntuación relativa a la carga horaria de actividades didácticas recibía un bono cuando la carrera era bien evaluada por los alumnos, las clases eran dictadas durante el turno noche o los cursos eran grandes. Cuanto más grandes fueran los recursos que captase el docente en proyectos de investigación, más puntos acumulaba. De la misma manera, actividades administrativas que implican encargos y responsabilidades mayores, tales como dirección y jefatura de departamento, rendían más puntos que la participación en comisiones que no generan trabajo extra. Quien se encargaba del montaje de las planillas con las puntuaciones era el propio Ivano Gutz, con la ayuda de una secretaría. En los pasillos del IQ-USP, se le denominaba a la metodología, en tono de broma, índice G, en referencia al conocido índice H, que mide cantidad e impacto de la producción científica. “Pero el índice G es mejor, por ser abarcador y tener en cuenta el desempeño reciente del investigador”, bromea Gutz. “El índice H es acumulativo y suministra una ventaja a quienes tiene más extensa trayectoria”. La divulgación de los resultados en 2006 y 2007 implicó algún malestar, pero la aceptó la mayoría. “Lo que había es la típica resistencia por parte de aquéllos que se sentían amenazados por los resultados. Como les mostramos que no se pretendía castigar a nadie, la misma fue disminuyendo”, subraya el profesor. La resistencia tenía una explicación: en 1988, se filtró en el periódico Folha de S.Paulo una lista, producida para uso interno por la rectoría de la USP, con nombres de investigadores que no habían publicado ningún trabajo científico entre 1985 y 1986. La llamada “lista de improductivos” generó un trauma y una controversia duradera.

Criterios refinados

Luego de la salida de Ivano Gutz de la jefatura en 2008, el departamento hizo una pausa en el proceso, que había generado dos evaluaciones. “Los jefes que vinieron a continuación delegaron la recolección de datos a las secretarías. Como éstas tenían otras atribuciones, el trabajo terminó adormecido”, dice Mauro Bertotti, quien reanudó la evaluación cuando llegó a la jefatura del departamento en 2012. Se refinaron muchos criterios, en el marco de un proceso que aún no ha concluido. En el caso de los artículos científicos, el peso ahora queda determinado directamente por el factor de impacto de la revista, y ya no por la raíz cuadrada del factor de impacto. “Sostenemos que la publicación de artículos debe tener un peso fuerte, proporcional a la calidad de la revista”, sostiene Bertotti. En la categoría captación de recursos, aparte de que existe un peso mayor para valores más altos, coordinadores de proyectos ganan un bono en la puntuación con relación a los demás miembros. En cada categoría, la puntuación se contabiliza separadamente y se normaliza según la mediana del departamento, con los pesos asignados a cada actividad, a fin de evitar que el desempeño elevado de un docente en un apartado opaque la performance de los restantes.

Uno de los recaudos que se tomaron consistió en profesionalizar el recabado de datos. Se contrató a una pasante para hacerse cargo de esta tarea, lo que incluye contactar a cada docente y estimularlo a declarar todo tipo de actividad que se encaje en la evaluación. La pasante es también es responsable de la divulgación de un boletín mensual con las actividades de los docentes, lo que incluye desde participaciones en tribunales de tesis hasta los reportajes publicados en la prensa en los cuales fueron entrevistados. “La intención es valorar todo lo que hagan los docentes”, enfatiza Bertotti.

En las discusiones sobre la reforma de los estatutos de la USP existe la propuesta de permitir que los departamentos retiren del régimen de dedicación exclusiva a los profesores con desempeño más endeble, llevándolos al régimen de dedicación parcial. Evaluaciones como la promovida por el Departamento de Química Básica podrían servir de referencia objetiva para este tipo de decisiones. “No sabemos si este cambio en el estatuto prosperará”, dice Gutz.

Los mentores del proceso de evaluación se preocupan con el hecho de que los criterios adoptados a veces no coinciden con las directrices para el ascenso dentro de la USP. “Podemos sostener que un docente debe ser reconocido por dictar muy buenas clases o participar en actividades de extensión, pero eso no será suficiente para elevarlo a la cima de la carrera”, pondera la profesora Silvia Serrano, quien dirige la comisión de evaluación. Gutz observa que la iniciativa podría erigirse en un instrumento para regular si un investigador puede o no brindar consultoría a empresas, por ejemplo. “Algunos años atrás, la Asociación Brasileña de la Industria Química, interesada en el exitoso modelo de innovación de Corea del Sur, trajo como conferenciante a un profesor y dirigente de un centro de investigación que también dio una charla en el Instituto de Química y nos contó cómo funcionaba eso en su país. Allá, docentes bien evaluados tienen la libertad de prestar consultoría a empresas. En tanto, quienes no logran dar cuenta de sus actividades académicas son advertidos y estimulados durante unos dos años. De proseguir siendo mal evaluados, puede procederse a su desvinculación”. Para el profesor, el proceso de evaluación muestra que es posible, pero no indispensable, destacarse en todas las actividades en que el docente se involucra. “Tenemos docentes que logran hacer un trabajo de excelencia en diversas áreas. Es justo que les sirvan de inspiración a los demás”, afirma Gutz.

Republicar