Las máquinas ya pueden “ver”, mediante el procesamiento e interpretación de la realidad que las rodea. Esto se ha vuelto una realidad gracias a los sistemas que simulan la cognición humana y obtienen información a partir de imágenes. Lo que hoy en día se denomina visión computarizada o computacional es una de las tecnologías que sostienen la ingeniería avanzada, e intervienen, sobre todo, en el monitoreo y en el análisis de diversos procesos y actividades. Científicos de diversos países, de Brasil inclusive, están abocados a perfeccionar esta tecnología, con miras a diversificar su uso. La meta es incorporarla en sistemas que ayuden al diagnóstico de enfermedades, a dispositivos de asistencia para que las personas con problemas de locución puedan comunicarse o en vehículos autónomos, entre otras aplicaciones.

“La visión computacional utiliza sistemas asociados a tecnologías de captura de imágenes y soporte para la toma de decisión basados en algoritmos de análisis o de inteligencia artificial”, dice el ingeniero mecánico Paulo Gardel Kurka, de la Facultad de Ingeniería Mecánica de la Universidad de Campinas (FEM-Unicamp), un importante centro nacional de investigación en el área. Los estudios con sistemas de procesamiento de imagen cobraron relevancia en los años 1970, con el aumento de la capacidad de procesamiento de las computadoras y con la creación de sensores electrónicos capaces de capturar imágenes y digitalizarlas. En las décadas posteriores, el avance de los estudios con materiales semiconductores y la miniaturización de la electrónica impulsó la creación de sistemas más sofisticados, capaces de obtener, procesar y analizar con mayor eficiencia las informaciones de esas imágenes.

Acta Visio

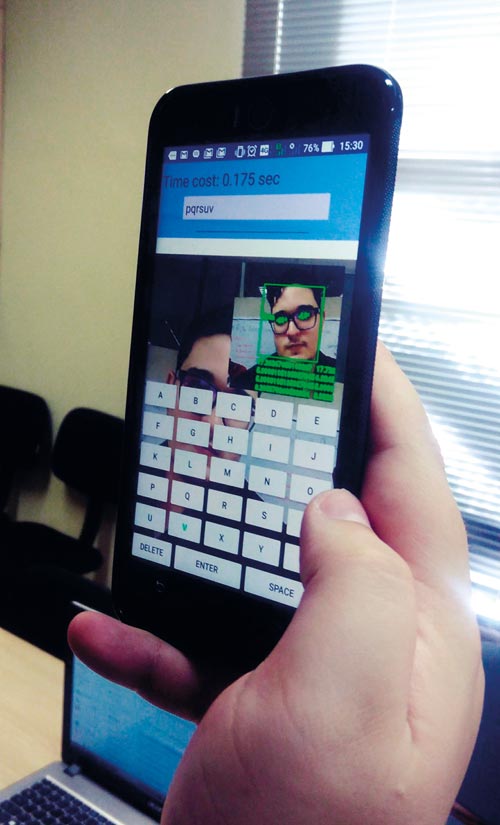

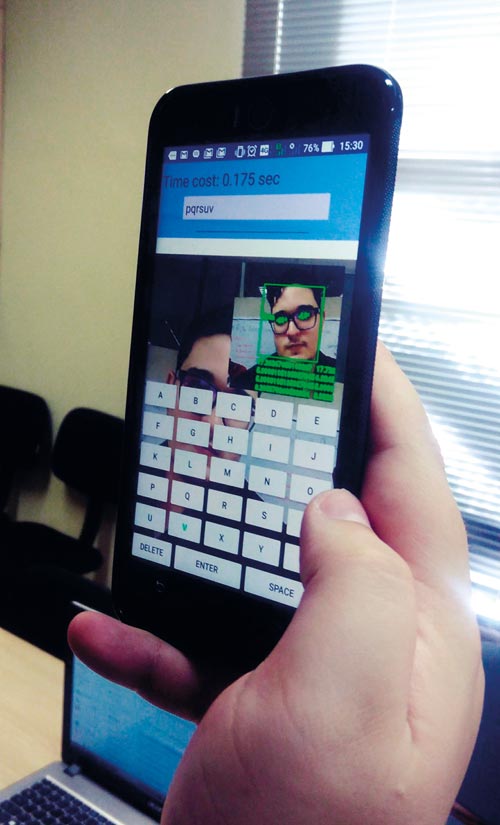

EyeTalk: esta aplicación utiliza la cámara del

smartphone para detectar comandos oculares y convertir el texto en voz

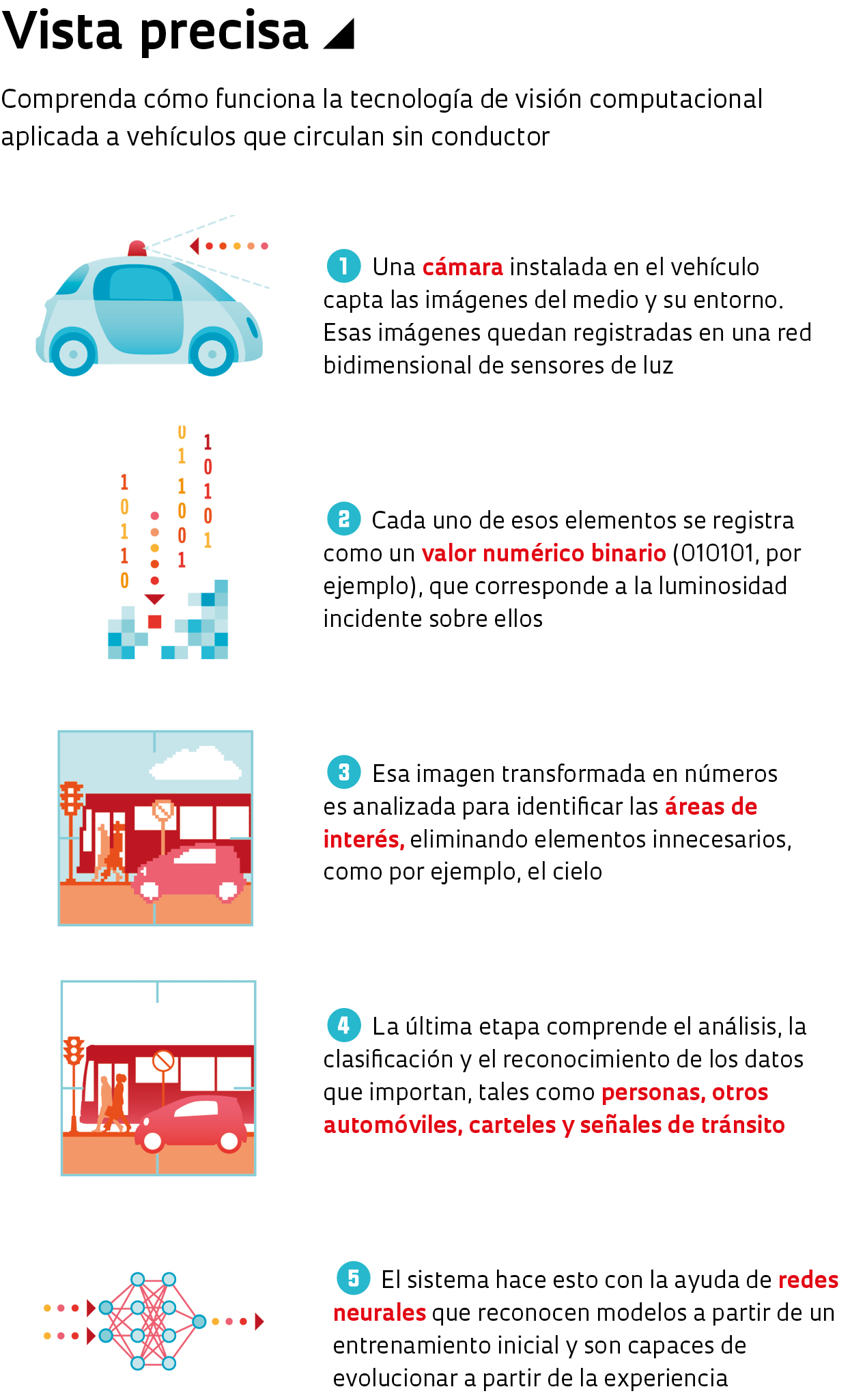

Acta Visio La tecnología de visión computacional se basa en tres etapas de procesamiento de imagen. La primera involucra la captura de la imagen por medio de un dispositivo, como por ejemplo, una cámara. Esa imagen queda registrada en una red bidimensional de elementos sensibles a la luz. Cada uno de esos elementos es capaz de almacenar una cifra numérica binaria, correspondiente a la intensidad luminosa que incide sobre ella. Los elementos de esa red corresponden a los píxeles que se utilizan para la exhibición de la imagen en una pantalla luminosa. “Esos datos se someten a técnicas de procesamiento para mejorar la calidad de la imagen y realzar o eliminar ciertas características que no agregan información al uso que se desea darle”, explica Kurka.

Esa segunda etapa se realiza por medio de técnicas que identifican y seleccionan las zonas de la red de elementos de la imagen que contienen datos relevantes. “Durante el procesamiento se definen las regiones de interés que se utilizan en los análisis posteriores, que servirán para adecuar las características de cada imagen a los objetivos que se pretende alcanzar”. La última etapa involucra el análisis, clasificación y reconocimiento de los datos de interés. Eso se hace tomando como base el tipo de aplicación para el cual se desarrolló cada sistema de visión computacional.

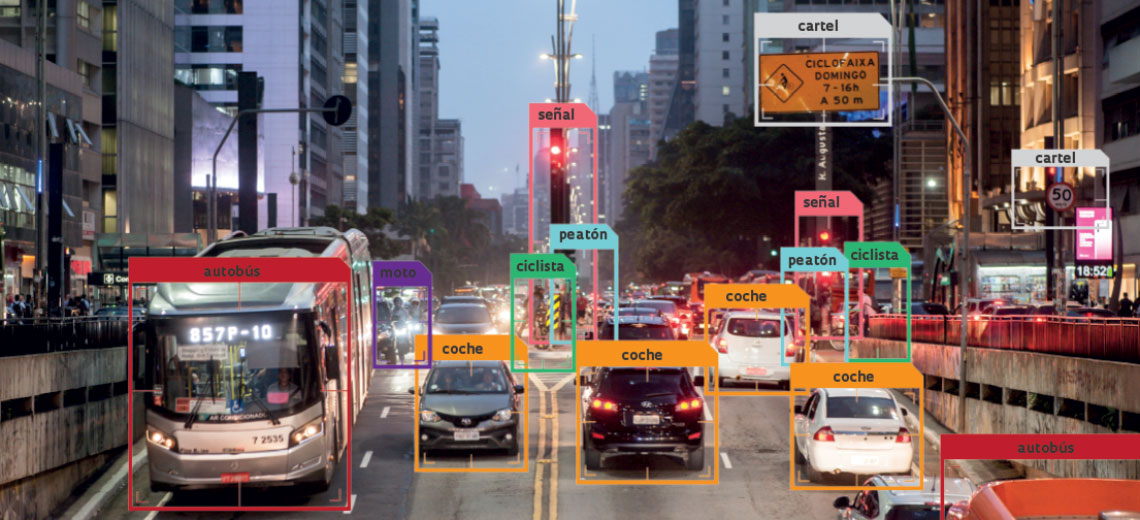

En 2018, el mercado global de sistemas de procesamiento de imágenes movilizó 11.900 millones de dólares, y podría llegar a 17.300 millones de dólares en 2023, según datos de la consultora estadounidense Markets and Markets. Siete de las veinte empresas que realizan más inversiones en esta tecnología se encuentran en Estados Unidos. Una de ellas es Google. La gigante del Valle del Silicio está abocada a la aplicación de esta tecnología en vehículos autónomos. La idea es equiparlos con cámaras y sensores capaces de producir, procesar y analizar imágenes, diferenciando personas de objetos y colaborando en su desplazamiento. Todo ello en tiempo real.

Los avances también se dan en el sector académico. Dos de los principales centros de investigación del área en el mundo, los institutos de tecnología de California (Caltech) y de Massachusetts (MIT), trabajan en sistemas de procesamiento de imágenes con diversas aplicaciones. Parte del conocimiento generado en el Caltech se utilizó para la creación de dispositivos de georreferenciación en los robots que se enviaron a Marte. En el MIT, se emplea esta tecnología para la identificación de objetos en lugares oscuros, en el perfeccionamiento de habilidades humanas en los robots, tales como sensibilidad y destreza, y en vehículos autónomos.

En Brasil, una de las aplicaciones más frecuentes de la visión computarizada es el monitoreo de los procesos industriales, uno de los pilares de la industria 4.0. Ese es el caso de Autaza, una startup en la localidad de São José dos Campos (SP), que ideó un sistema de inspección industrial en donde las cámaras fotografían piezas en una línea de producción y utilizan recursos de inteligencia artificial para detectar posibles defectos.

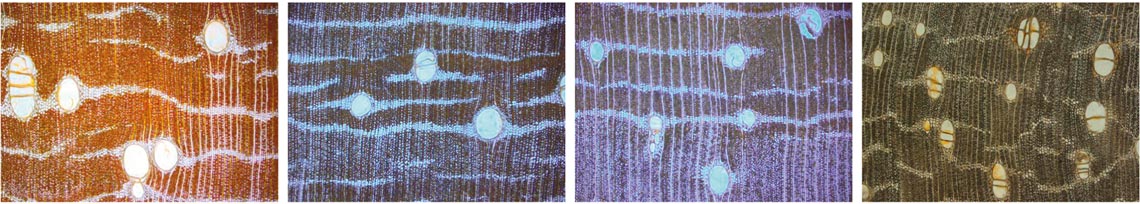

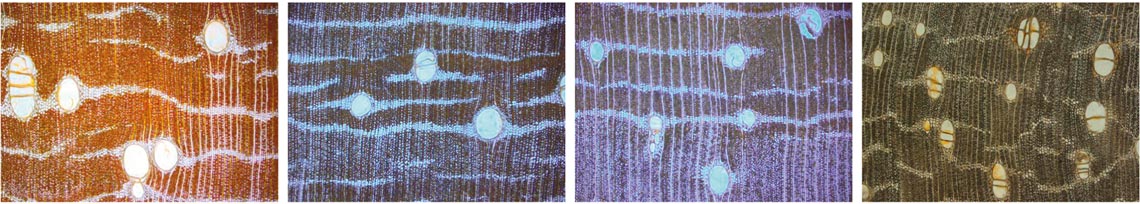

Estos sistemas también los utiliza en el país la industria maderera. Científicos de la Universidade Estadual Paulista (Unesp), en su campus de Itapeva, y del Instituto de Ciencias Matemáticas y de la Computación de la Universidad de São Paulo (ICMC-USP), en São Carlos, crearon una tecnología capaz de indicar la calidad de las tablas y la especie de árbol a la cual pertenecen. El sistema, que se encuentra en uso en la maderera Sguario, de la localidad de Itapeva (SP), verifica si la madera es de origen legítimo y la separa según el tipo de árbol, algo que puede incidir el precio de venta.

Annals of Forest Science

Los sistemas de procesamiento de imágenes se utilizan en establecimientos madereros para indicar la calidad de las tablas y la especie de árbol a la cual pertenecen

Annals of Forest ScienceMejora de la comunicación

La visión computacional también se está utilizando para ayudar a las personas con limitaciones físicas y pacientes hospitalarios. La startup paulista Hoobox Robotics, fundada en 2016 por investigadores de la Unicamp, creó un sistema de reconocimiento facial que capta y traduce expresiones en comandos para controlar el desplazamientos de una silla de ruedas, sin necesidad de sensores corporales. La solución, denominada Wheelie 7, puede identificar y reconocer más de 10 expresiones, tales como el arqueo de las cejas o una guiñada de ojos. Por medio de una cámara que enfoca el rostro del usuario, el sistema capta las expresiones, que son interpretadas a continuación por un algoritmo. Un programa las transforma en comandos, tales como avanzar o girar a la izquierda.

La solución fue desarrollada con ayuda del programa Investigación Innovadora en Pequeñas Empresas (Pipe) de la FAPESP. Por ahora, la silla de ruedas se comercializa solamente en Estados Unidos a través de una suscripción mensual de 300 dólares. Mediante un convenio con el Hospital Albert Einstein, de São Paulo, Hoobox ya está testeando la tecnología para detectar comportamientos humanos, tales como agitación o espasmos, en pacientes internados en unidades de terapia intensiva (UTIs).

En una misma sintonía, el ingeniero mecánico Marcus Lima, investigador de la FEM-Unicamp, aplicó la visión computarizada a la creación de una aplicación para dispositivos móviles que se vale de la cámara frontal para detectar comandos oculares, permitiendo la comunicación por medio de la conversión del texto en voz. El Eye Talk, tal como se bautizó a ese aplicativo, es fruto de investigaciones efectuadas en la esfera del Pipe. Según Lima, la intención inicial era crear un sistema para la captura de comandos oculares para controlar el desplazamiento de drones. “Durante la realización del proyecto, noté que podría adaptar la tecnología para que pudieran utilizarla personas con compromiso del habla”, recuerda.

Hoobox

El dispositivo creado por la empresa Hoobox capta expresiones faciales…

HooboxLa solución funciona como un teclado virtual, con teclas que destellan en forma secuencial. La idea es simple: una tableta o un smartphone con la aplicación se acoplan a un soporte frente al usuario. La cámara frontal queda enfocada a los ojos de la persona, quien con un guiño elige las letras que desea para armar palabras y frases. Acto seguido, esas frases se transforman en audio mediante una voz digital. La solución es similar a la que utilizaba el físico británico Stephen Hawking (1942-2018), quien padecía de esclerosis lateral amiotrófica (ELA) y pasó la mayor parte de su vida confinado en una silla de ruedas sin poder hablar. “El problema”, dice Lima, “reside en que los modelos disponibles pueden llegar a costar hasta 15 mil libras esterlinas [alrededor de 75 mil reales], un costo inaccesible para la mayoría de la gente”.

En la actualidad, Lima está al frente de Acta Visio, una empresa fundada en 2017 para desarrollar soluciones basadas en la visión computacional. El investigador y su equipo trabajan en un prototipo de un sistema de procesamiento de imagen para monitorear la higienización de las manos de los profesionales de la salud. El objetivo es reducir las infecciones hospitalarias y proveer datos cuantitativos que puedan ayudarle al administrador del hospital en el análisis de los procedimientos de higienización. Los primeros test se realizarán en abril, en el Hospital Universitario Cajuru, en Curitiba, en colaboración con la empresa de gestión hospitalaria 2iM.

Hoobox

…y las traduce en comandos para controlar una silla de ruedas

HooboxUn diagnóstico más preciso

También en el área de la salud, los sistemas de procesamiento de imagen también se utilizan para la identificación de biomarcadores que ayudan al diagnóstico, el pronóstico y el tratamiento de algunos tipos de cáncer, como en el caso de los de mama. Muchos de esos tumores se detectan cuando la enfermedad ya se encuentra en estado avanzado. La detección precoz pasa por el examen clínico y por la mamografía, que se realiza con un aparato de rayos X capaz de identificar lesiones iniciales con potencial cancerígeno. En muchos casos, para arribar a un diagnóstico más preciso, se recurre a la biopsia, esto es, la extracción de un fragmento del tejido sospechoso para su análisis. En promedio, de cada ocho biopsias que se realizan tan solo una da positivo.

Una innovación introducida por Paulo Mazzoncini de Azevedo Marques, docente de informática biomédica y física médica en la Facultad de Medicina de Ribeirão Preto de la USP, permite la identificación de patrones asociados a ese tipo de tumores, lo cual permite reducir el número de biopsias. “Apelamos a la visión computacional para crear un algoritmo capaz de detectar y analizar microcalcificaciones, pequeños cristales de calcio existentes en la mama representados como pequeños puntos claros en la imagen, indicando si están asociados a una lesión benigna o maligna [cáncer]”, dice. “El algoritmo analiza cada pixel de la imagen en zonas específicas y, a partir de la extracción de atributos cuantitativos, identifica variaciones que podrían estar asociadas a un patrón sospechoso”.

En el segmento de la salud, la visión computacional puede colaborar en el diagnóstico del cáncer y de enfermedades autoinmunes

Ese modelo también puede adaptarse para el reconocimiento de pautas que ayuden al diagnóstico y tratamiento en casos de tumores de pulmón y enfermedades reumáticas autoinmunes. Con base en la variación de tonalidades grises en las imágenes de lesiones sospechosas captadas por los aparatos de rayos X, resonancia magnética y tomografía computada, y valiéndose de algoritmos de inteligencia artificial, se pueden analizar en forma aislada las regiones sospechosas, comparando sus características con las de las lesiones identificadas en las imágenes de otros pacientes diagnosticados con anterioridad.

“Nuestra intención es que el sistema utilice los datos acumulados y aprenda a partir de la experiencia, siendo capaz de establecer pautas que ayuden al médico a reconocer dónde están los hallazgos significativos en las imágenes, sus características y si los mismos están asociados a tumores más agresivos”, explica el investigador. La solución está siendo perfeccionada a partir de las informaciones disponibles en bases de datos clínicas locales y públicas. La idea es entrenar al sistema y perfeccionar su capacidad de reconocimiento de patrones asociados a esas enfermedades.

Proyectos

1. Inspección de calidad automática de carrocerías de automóviles (nº 17/25873-8); Modalidad Investigación Innovadora en Pequeñas Empresas (Pipe); Investigador responsable Jorge Augusto de Bonfim Gripp (Autaza Tecnologia); Inversión R$ 1.452.695,60

2. Wheelie, tecnología innovadora para guiar sillas de ruedas (nº 17/07367-8); Modalidad Investigación Innovadora en Pequeñas Empresas (Pipe); Investigador responsable Paulo Gurgel Pinheiro (Hoobox Robotics); Inversión R$ 723.814,04

3. Proyecto, desarrollo y montaje de un prototipo de sistema de rastreo ocular adosado en gafas de visión en primera persona para el control de un dron destinado a individuos tetrapléjicos (nº 16/15351-1); Modalidad Investigación Innovadora en Pequeñas Empresas (Pipe); Investigador responsable Marcus Vinicius Pontes Lima (Acta Visio); Inversión R$ 57.974,44

4. Desarrollo e implementación de ontología de dominio en radiología y diagnóstico por imágenes para la práctica clínica en hospital escuela (nº 11/08943-6); Modalidad Ayuda a la Investigación – Regular; Investigador responsable Paulo Mazzoncini de Azevedo Marques (USP, campus de Ribeirão Preto); Inversión R$ 55.731,32

Republicar