Las instituciones científicas y de educación superior de Brasil están empezando a formular recomendaciones para el uso de la inteligencia artificial (IA), especialmente la generativa, en la enseñanza, la investigación y la extensión. La popularización de programas informáticos como ChatGPT, capaces de generar texto, imágenes y datos, ha planteado dudas sobre los límites éticos del uso de estas tecnologías, fundamentalmente en la escritura académica. Los docentes han buscado nuevas formas de evaluar el trabajo de los alumnos, tratando de eludir los riesgos del uso indebido de la IA. En líneas generales, las directrices apuntan a un uso transparente de la misma y advierten sobre el peligro de infringir los derechos de autor, incurrir en plagio, generar desinformación y replicar sesgos discriminatorios que estas herramientas pueden reproducir.

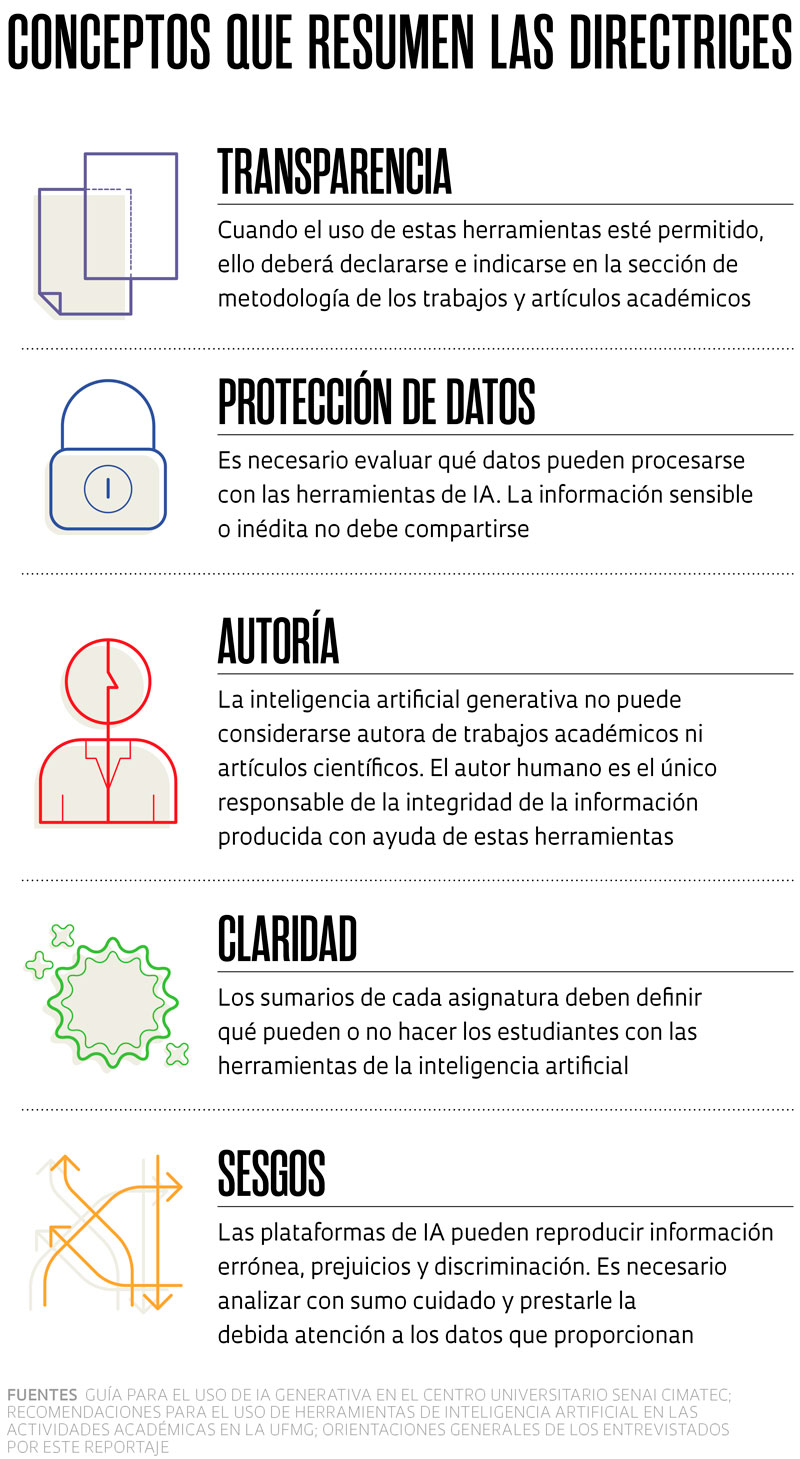

En febrero, el centro universitario Senai Cimatec, de Bahía, publicó una guía orientativa para su comunidad académica al respecto de la IA generativa que se basa en tres principios: transparencia; “centralidad en la persona humana”, es decir, que se preserve el control humano sobre la información generada por IA, ya que su uso debe comportar un beneficio para la sociedad, y énfasis en la privacidad de los datos, especialmente en aquellas actividades que comprenden contratos con empresas a través de convenios para el desarrollo y transferencia de tecnologías. Es sabido que esta herramienta puede almacenar la información compartida en las plataformas de IA, vulnerando la confidencialidad de los datos. “No podemos soslayar que, así como nosotros aprendemos con estas herramientas, ellas también aprenden de nosotros”, subraya la ingeniera civil Tatiana Ferraz, prorrectora administrativo-financiera de Senai Cimatec y coordinadora de la guía. Una actualización del reglamento disciplinario de la institución incluye ahora sanciones para los estudiantes que incumplan las normas.

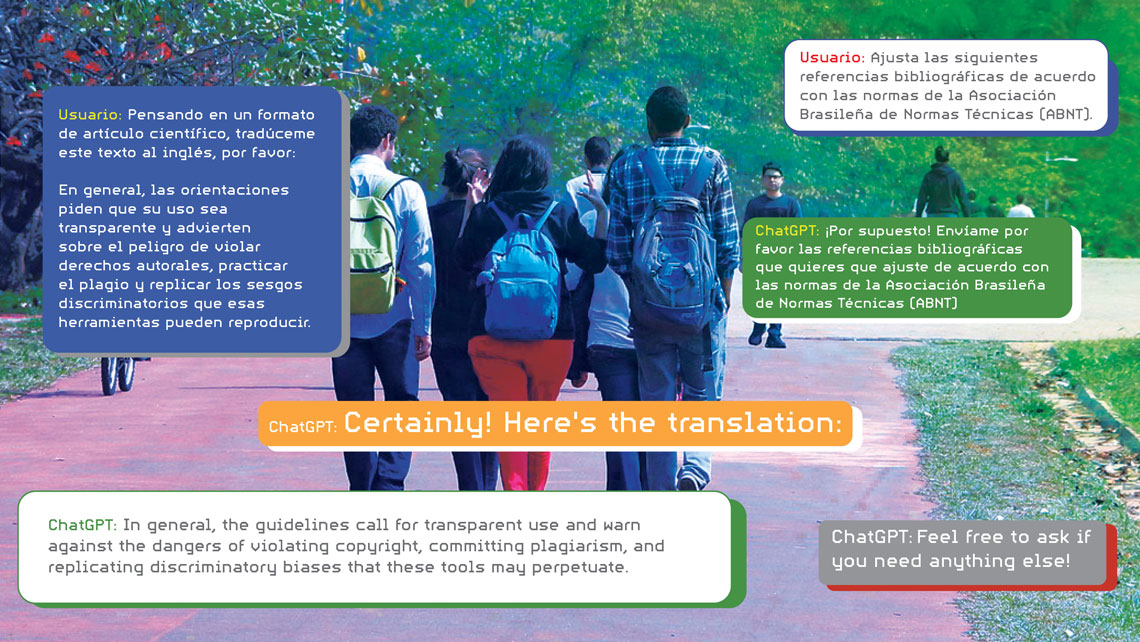

La guía autoriza a los profesores a utilizar software de detección de plagio cuando lo consideren necesario, aunque estos no tengan un 100 % de precisión a la hora de reconocer contenidos producidos por IA. Las herramientas no pueden citarse como coautoras de trabajos académicos, pero se permite su aplicación como ayuda en los procesos de investigación y en la corrección de escritos académicos. A tal fin, todos los comandos utilizados ‒las preguntas e instrucciones facilitadas a la herramienta, conocidas como prompts‒ y la información original generada por la IA deben describirse en la metodología del trabajo y adjuntarse como material suplementario.

Otras instituciones brasileñas están siguiendo el mismo camino. “La universidad no debe prohibir, sino crear directrices para un uso responsable de estas herramientas”, dice el científico de la computación Virgílio Almeida, coordinador de una comisión de la Universidad Federal de Minas Gerais (UFMG), que propuso recomendaciones para el uso de tecnologías de IA en la institución, que se presentaron a la comunidad académica en mayo. Las sugerencias servirán como base para la creación de una política institucional con normas y reglamento y un comité permanente de gobernanza.

Abarcan las áreas de enseñanza, investigación, extensión y administración y sus principios son la transparencia en el uso de estas herramientas, el cuidado en la protección y la privacidad de los datos, con la desinformación y los sesgos discriminatorios que estas tecnologías pueden reproducir. “Una de las propuestas es que la universidad invierta en cursos de capacitación en IA para docentes, investigadores, no docentes y alumnos”, explica Almeida. En la enseñanza, una de las directrices apunta que los sumarios de los programas de las materias de las carreras de grado y del posgrado de la UFMG deben informar lo que está permitido hacer con estas tecnologías. En la investigación, el énfasis está puesto en la transparencia: es necesario detallar cómo se ha utilizado la IA en el proceso científico y cuáles son los sesgos que puede conllevar. Otro de los ítems recomendados es el análisis cuidadoso de los resultados generados por IA para evitar datos falsos.

En mayo, la Universidad de São Paulo (USP) publicó un dosier en la Revista USP sobre la inteligencia artificial en la investigación científica y ha organizado reuniones y debates para tratar el tema. “En líneas generales, la sugerencia es estudiar cómo incorporar su uso en la enseñanza y en la investigación y determinar cuáles serían sus limitaciones éticas y su potencial”, dice la abogada Cristina Godoy, de la Facultad de Derecho de Ribeirão Preto (FDRP-USP), integrante de un grupo de investigadores que elaboraron propuestas para la universidad, como la necesidad de diseñar guías orientativas para las carreras de grado y el posgrado. Hay advertencias al respecto del cuidado que debe tenerse con la confidencialidad de los datos de investigación sensibles o inéditos, como son las tesis doctorales y tesinas de maestría, como así también sobre la necesidad de explorar nuevas maneras de evaluar los trabajos en el aula. Las recomendaciones se formularon en el marco de un evento celebrado en marzo de 2023 y un grupo de trabajo las está analizando.

El uso de la IA en la investigación científica no es una novedad. Las herramientas de aprendizaje automático y de procesamiento del lenguaje natural ya se utilizan para analizar patrones en grandes volúmenes de datos. Pero con el avance de las plataformas que utilizan IA generativa, varias universidades de Estados Unidos y Europa han creado directrices en este sentido que han servido de inspiración a instituciones brasileñas. En el Senai Cimatec, las guías de las universidades de Utah (EE. UU), de julio de 2023, y de Toronto (Canadá), aún en fase preliminar, han servido como orientación al grupo de trabajo, al igual que la guía de inicio rápido ChatGPT y la inteligencia artificial en la educación superior, de la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (Unesco), de abril de 2023.

En este escenario, ha habido casos de docentes que comenzaron a pedirles a sus alumnos que hicieran presentaciones orales, trabajos en el aula o incluso a mano, en papel. Godoy, de la USP, quien solía pedir escritos sobre los artículos estudiados, pasó a exigir a sus alumnos que presenten esquemas con mapas mentales que muestren las conexiones entre los textos estudiados en clase.

En 2024, ella desarrolló una actividad de investigación en el ámbito del Centro de Inteligencia Artificial (C4AI) de la USP, patrocinado por IBM y la FAPESP, con estudiantes de iniciación a la investigación científica, maestría y doctorado en computación, ciencia política y derecho en la que debían desarrollar prompts en ChatGPT para analizar las emociones ‒una técnica que clasifica las opiniones en positivas, negativas o neutras‒ entre los usuarios de X (antes Twitter) al respecto de la IA. Los datos formarán parte de un artículo que se encuentra en proceso de redacción. Parte del trabajo consistirá en describir la metodología y los prompts utilizados. Puesto que no es necesario generar un algoritmo específico para la actividad, la herramienta aceleró el proceso de análisis de los datos; según Godoy, si hubieran tenido que hacer todo desde cero el trabajo hubiera llevado ocho meses, pero con ChatGPT bastaron dos meses.

“Algunas instituciones del Poder Judicial ya están estudiando la posibilidad de utilizar la IA para optimizar las etapas de análisis de los expedientes. Por ende, vedar su uso no representa una ventaja para los estudiantes, que necesitan estar preparados de forma crítica y responsable”, reflexiona la abogada. Según su punto de vista, los alumnos con mejor desempeño en las redacciones y exámenes son los que desarrollan los mejores prompts. “Para formular buenas preguntas a la plataforma de IA y conseguir el resultado deseado es necesario identificar con claridad el problema que pretende abordarse”, dice Godoy.

Léo Ramos Chaves / Revista Pesquisa FAPESPEjemplo de un ejercicio que el administrador de empresas Ricardo Limongi, de la UFG, realiza en el aula para ayudar a sus alumnos a entender conceptos de la disciplina de estadísticaLéo Ramos Chaves / Revista Pesquisa FAPESP

En el primer semestre de 2024, el científico de la computación Rodolfo Azevedo, del Instituto de Computación de la Universidad de Campinas (Unicamp), impartió un curso piloto de introducción a la programación con asistente de código, junto con el ingeniero electrónico Jacques Wainer, también docente de la Unicamp. Los alumnos, estudiantes de la carrera de ingeniería alimentaria, aprendieron a programar por primera vez con ChatGPT como asistente en el aula, utilizando el lenguaje Phyton. “El objetivo era enseñarles los rudimentos de la programación, enfocándonos en desarrollar la habilidad de descomponer un problema en etapas menores e ir resolviéndolas paso a paso. Los medios siempre han ido transformándose, desde que aparecieron las primeras tarjetas perforadas”, dice Azevedo.

A su juicio, el uso de IA generativa ha hecho que los alumnos puedan centrarse en problemas más complejos. “Antes era necesario programar desde cero, lo que llevaba más tiempo, pero ahora la IA escribe los códigos a partir de las instrucciones que le proporciona el alumno. El estudiante es capaz de analizar los errores más a fondo, que siempre los hay, y proponer soluciones y mejoras más elaboradas”, dice el científico de la computación, subrayando que a esta tecnología ya la utilizan los programadores de muchas empresas para optimizar sus procesos. También vislumbra otros usos en el ámbito académico. “Estas herramientas pueden reducir la desigualdad entre los investigadores cuya lengua materna no es el inglés, ya que pueden pedirle a la IA que mejore las traducciones de sus artículos”, pondera.

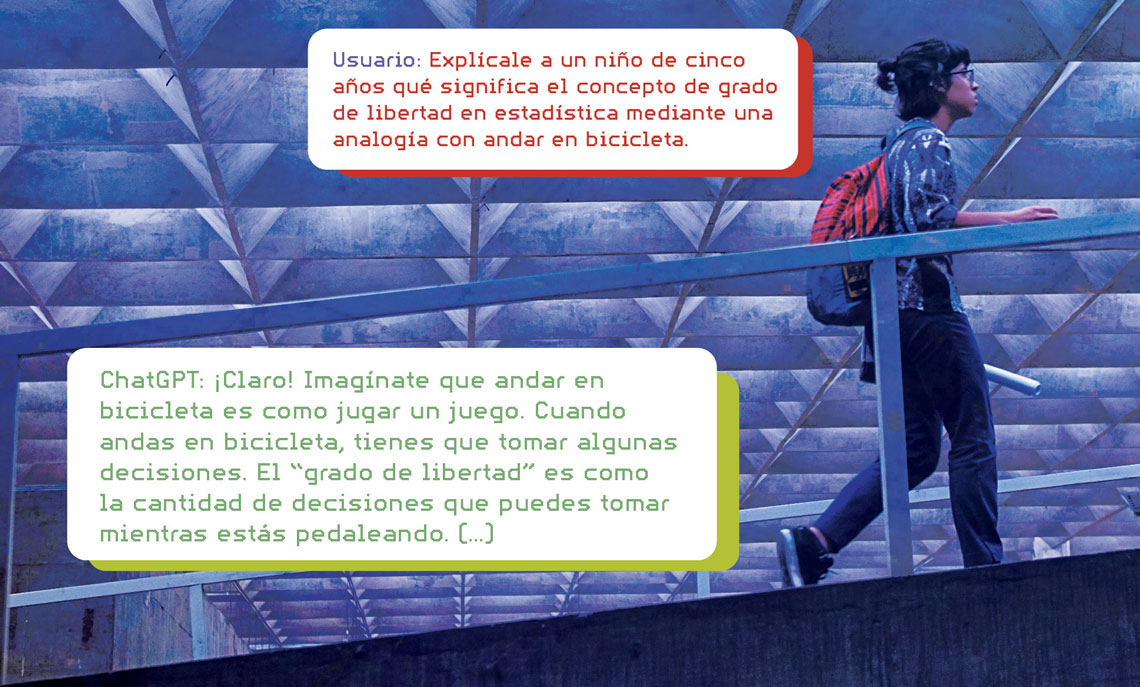

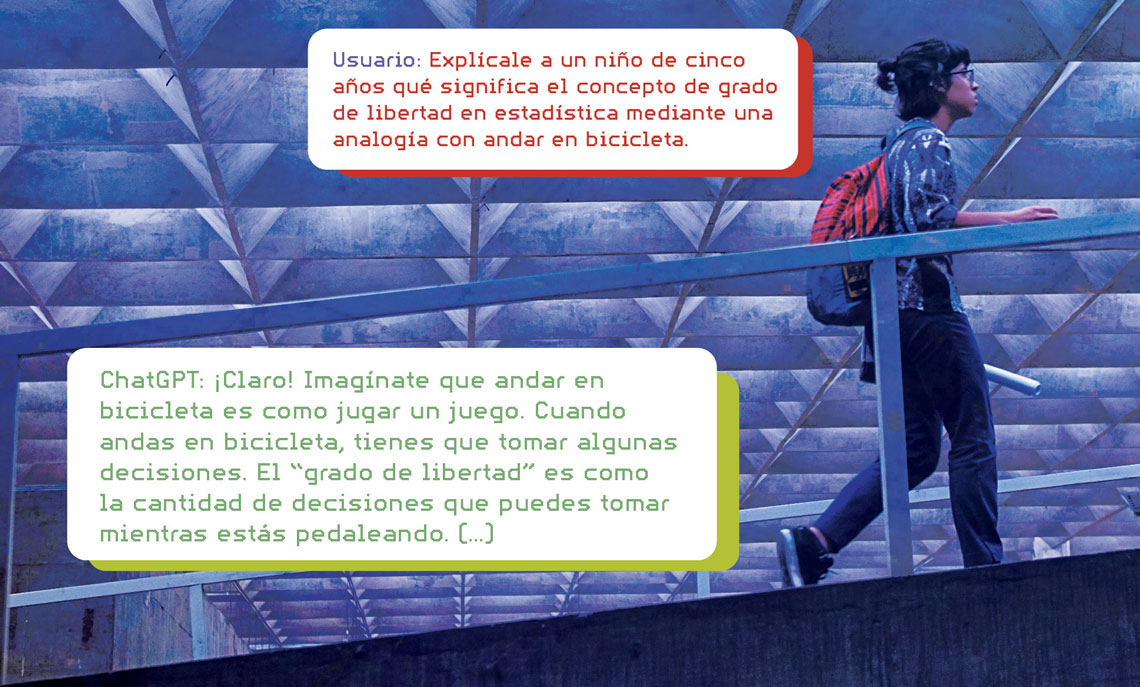

El administrador de empresas Ricardo Limongi, de la Universidad Federal de Goiás (UFG), intenta enseñarles a sus alumnos cómo utilizar estas herramientas desde una perspectiva crítica. “Les explico que yo las uso y que ellos también pueden hacerlo. Eso no es hacer trampa”, dice. En clase, abre plataformas de IA y les muestra a los alumnos cómo se hace un prompt, por ejemplo. En una de las asignaturas que imparte ‒estadística‒, Limongi suele recurrir a la ayuda de la IA generativa para explicarles conceptos que les cuestan entender, siempre verificando las respuestas. “Salen analogías muy buenas”, dice.

Autor de un artículo sobre la aplicación de la IA en la investigación científica publicado en abril de 2024 en la revista Future Studies Research Journal, Limongi ha sido invitado a dictar conferencias sobre el tema en universidades. En estos encuentros, organiza talleres donde presenta herramientas de IA generativa que ha utilizado con sus alumnos para optimizar los procesos de investigación.

En las revistas científicas

Además de las universidades, las mayores editoriales científicas del mundo han divulgado normas para el uso de IA generativa. En una encuesta que llevó a cabo la revista Nature en septiembre de 2023, en la que participaron más de 1.600 científicos, casi un 30 % afirmó haber utilizado esta tecnología como ayuda para la redacción de manuscritos y alrededor de un 15 % para redactar solicitudes de financiación. Por su parte, un estudio publicado en la revista British Medical Journal (BMJ) en enero de 2024, indicó que, entre las 100 mayores editoriales de revistas científicas, el 24 % ha proporcionado orientaciones acerca del uso de la IA, y entre las 100 revistas mejor clasificadas, el 87 % estableció reglas en ese sentido. Entre las editoriales y revistas que incorporaron directrices, el 96 % y el 98 %, respectivamente prohibieron la inclusión de la IA como autora de un artículo.

El grupo editorial Springer Nature actualiza sus normas de manera permanente y establece que el uso de IA generativa debe documentarse en la sección de métodos del manuscrito. Las imágenes y videos generados por IA están prohibidos. Los revisores tampoco pueden utilizar software de IA generativa para evaluar artículos científicos, ya que contienen información de investigación inédita. La editorial Elsevier permite el uso de IA para mejorar el lenguaje y la legibilidad de los textos, “pero no para reemplazar tareas esenciales del autor, como la producción de insights científicos, pedagógicos o médicos, sacar conclusiones científicas o formular recomendaciones clínicas”.

En Brasil, la biblioteca científica electrónica SciELO publicó una guía de uso de herramientas y recursos de IA en septiembre de 2023. “En sintonía con las editoriales internacionales, uno de los puntos principales establece que la IA no puede considerarse como autora de un trabajo”, explica Abel Packer, coordinador de SciELO. El manual exige a los autores que declaren cuando utilizan estas herramientas: aquellos que lo omitan estarán incurriendo en una falta ética grave. Con todo, el documento incentiva el uso de la tecnología en la preparación, redacción, revisión y traducción de los artículos. “Como lo vemos nosotros, de aquí a cinco años la comunicación científica cambiará radicalmente y el uso de estas herramientas será ubicuo”, dice Packer. En su opinión, estas herramientas pronto desempeñarán un papel auxiliar en los procesos de evaluación y revisión de los manuscritos enviados a las revistas.

Artículos científicos

LIMONGI, R. The use of artificial intelligence in scientific research with integrity and ethics. Future Studies Research Journal: Trends and Strategies. v. 1, n. 16. abr. 2024.

GANJAVI, C. et al. Publishers’ and journals’ instructions to authors on use of generative artificial intelligence in academic and scientific publishing: bibliometric analysis. BMJ, v. 384. 31 ene. 2024.

Republicar