Federico Ronchetti/ CERN

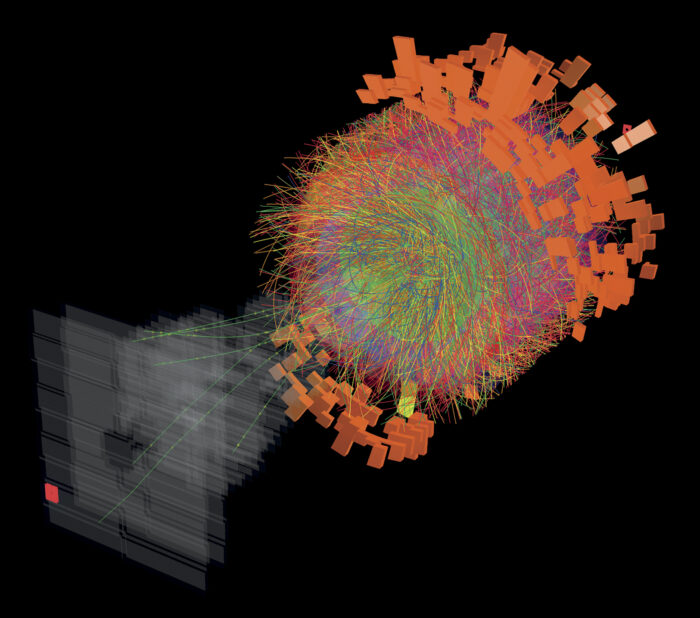

Imagen por computadora que representa a las partículas generadas por la colisión de núcleos de plomoFederico Ronchetti/ CERNLa Organización Europea para la Investigación Nuclear (Cern), lanzó a comienzos del mes de mayo un desafío dirigido a los científicos de la computación con el objetivo de promover el desarrollo de programas de inteligencia artificial para el análisis de datos. Con la meta de dilucidar la constitución básica de la materia, los físicos del Gran Colisionador de Hadrones (LHC, por sus siglas en inglés), el mayor acelerador de partículas del mundo, ubicado en los alrededores de Ginebra, en Suiza, se proponen aumentar al menos 20 veces el número de colisiones de partículas efectuado en el laboratorio en la próxima década. El aumento de la cantidad de esos eventos, superará la capacidad actual de análisis del LHC, donde se producen cientos de millones de colisiones cada segundo. Los detectores del acelerador registran información de toda partícula que los atraviesa, pero almacenan y reconstruyen las trayectorias solamente de aquellas colisiones cuyos resultados son más interesantes. La selección de esas colisiones se realiza por medio de algoritmos de reconocimiento estándar, aunque se trata de un proceso lento, comentó la cientista de la computación Cécile Germain en la revista Nature. La apuesta a desarrollar algoritmos que emplean el aprendizaje de máquina surgió a partir de un convenio entre el Cern y la firma Kaggle Competições. Cientos de gigabytes de información sobre colisiones de partículas quedaron a disposición de los competidores que, en los próximos tres meses, utilizarán la base para probar sus algoritmos y reconstruir las trayectorias de las partículas en forma precisa. Los mejores algoritmos seleccionados en la primera etapa de la competencia serán premiados en el mes de julio de este año en Río de Janeiro, en el marco del Congreso Mundial de Ciencias de la Computación. Los premios son de 5 mil, 8 mil y 12 mil dólares. El maratón finalizará en el mes de diciembre en Montreal, Canadá.

Republicar