El título de este artículo, “Cuando la evidencia es un espejismo”, según la interpretación de un programa de IADALL-E

Un consorcio de investigadores de Brasil, Estados Unidos e Italia está desarrollando un conjunto de herramientas computacionales con el objetivo de detectar en forma automática la existencia de adulteraciones o duplicaciones de imágenes de artículos científicos, un tipo de mala conducta muy habitual cuya identificación, aún en la actualidad, depende en gran medida de la mirada de una persona avezada. En un artículo publicado a finales de octubre en la revista Scientific Reports, una publicación del grupo Nature, el equipo presentó una evaluación preliminar del desempeño del Sila (Análisis de Imágenes Científicas). Se trata de un sistema de apoyo destinado a revisores y editores de revistas académicas capaz de procesar archivos en formato de artículos PDF, extraer sus imágenes en forma automática –eventualmente rastreando copias en alta resolución puestas a disposición por los autores o las publicaciones– y posteriormente utilizar algoritmos entrenados para detectar posibles adulteraciones.

Como resultado de ello, el software informa si ha encontrado pruebas de “posprocesamiento” de imágenes, por ejemplo, indicios de sectores clonados o cambiados de lugar, o bien si una foto presenta similitudes con otras publicadas previamente, indicando también, en formato gráfico, cuál es su procedencia. El Sila adopta un modelo cooperativo entre la inteligencia artificial y la humana. Aunque detecta contenidos sospechosos automáticamente, su valoración solamente es indicativa: luego le cabe a un experto verificar esos indicios y confirmar si realmente constituyen adulteración. El análisis se hizo a partir del material recopilado de 988 artículos científicos retractados, en los que se constató la manipulación o reutilización de figuras. “La herramienta se basa en principios avanzados de procesamiento de imágenes, técnicas de pericias forenses y soluciones de visión por computadora e inteligencia artificial para proporcionar análisis que ayuden a los expertos humanos a decidir si los sucesos descubiertos son legítimos o no”, dice uno de los autores, Anderson Rocha, docente y director del Instituto de Computación de la Universidad de Campinas (Unicamp), en donde coordina el Laboratorio de Inteligencia Artificial (Recod.ai).

En la evaluación divulgada en el trabajo, los módulos que componen el sistema exhibieron un rendimiento dispar. En las tareas relacionadas con la clasificación del contenido de los artículos, por ejemplo, la respuesta de los algoritmos desarrollados resultó insuficiente. En otras, como la detección de zonas con signos de desplazamiento de imágenes y la captación de indicios de duplicación, se obtuvieron resultados más sensibles que los logrados mediante la observación humana, incluso generando falsos positivos. “Seguimos trabajando para perfeccionar el Sila, ya que aún hay bastante margen de mejora”, explica Rocha.

El próximo paso es crear algoritmos que reconozcan los artículos producidos por las “fábricas de papers”

Los algoritmos y las bases de datos que emplearon quedaron a disposición en repositorios de acceso abierto y la idea es que otros investigadores ayuden a probar y perfeccionar el rendimiento de la herramienta. El consorcio es financiado por la Agencia de Proyectos de Investigación Avanzada en Defensa (Darpa) y la Oficina de Integridad Científica (ORI), ambos de Estados Unidos. En Brasil, cuenta con el apoyo de la FAPESP en el marco de un proyecto temático dirigido por Rocha. “Diseñamos el sistema contemplando las necesidades de la ORI, que nos formuló el pedido”, dice. La idea es que la ORI y la Darpa evalúen el conjunto de herramientas en instituciones públicas y entablen asociaciones con las editoriales de revistas académicas.

El autor principal del estudio, Daniel Moreira, se doctoró en la Unicamp bajo la dirección de Rocha y es investigador en las universidades de Notre Dame y Loyola Chicago, ambas en Estados Unidos. Todas las etapas del trabajo fueron supervisadas por Edward Delp, docente de ciencias de la computación en la Universidad Purdue (EE. UU.). También son miembros del consorcio científicos de instituciones italianas, entre ellas la Universidad de Nápoles Federico II y el Instituto Politécnico de Milán. La iniciativa forma parte de un proyecto más amplio que apunta a crear algoritmos de inteligencia artificial para la detección de la “realidad sintética”, es decir, fotografías, audios y videos falsificados de todo tipo (lea en Pesquisa FAPESP, edición nº 321).

Una de las ventajas del Sila reside en que abarca un ciclo completo de tareas de análisis de imágenes, desde la extracción hasta el análisis, y está previsto que se convierta en una herramienta abierta y disponible para cualquier tipo de usuario. En los últimos tiempos han aparecido en el mercado soluciones tecnológicas de esta índole, pero apuntan a resolver tareas específicas y son comercializadas por empresas. Una de ellas es Image Twin, un software desarrollado por una startup de Viena (Austria), que detecta la reutilización y el duplicado de imágenes en artículos. Diez revistas editadas por la Asociación Estadounidense para la Investigación del Cáncer (AACR) y otras dos vinculadas a la Sociedad Estadounidense de Investigación Clínica han estado probando, hasta ahora con buenos resultados, un programa de la empresa israelí Rehovot, diseñado para detectar fotos duplicadas o con partes rotadas, invertidas o estiradas. “Hasta ahora estamos bastante satisfechos con los resultados”, declaró a la revista Nature el director de operaciones de la AACR, Daniel Evanko.

Opciones en estilo surrealista generadas por un programa de inteligencia artificial a partir del comando “Imagen falsificada de una prueba western blot”DALL-E

Desde el advenimiento de la fotografía, las imágenes se han utilizado como evidencias de resultados científicos. En algunos casos, reflejan el hallazgo en sí mismo: como en el caso de la fotografía tomada por la química británica Rosalind Franklin, que reveló la estructura del ADN en 1952 y sirvió como base del artículo firmado por James Watson y Francis Crick. Con la transición de la fotografía analógica a la digital, las herramientas informáticas de edición, como el programa Photoshop, permitieron que los investigadores retocaran los archivos con suma facilidad, resaltando áreas de interés, tales como las “bandas” en los resultados de las pruebas western blot, un método utilizado en el ámbito de la biología molecular para identificar proteínas. “La mayoría de estas ediciones son legítimas. No hay inconveniente en calibrar el brillo o el contraste para que la visualización del resultado sea más sencilla”, dice Rocha. “Pero hay ediciones que comprometen la integridad y, a veces, esto claramente apunta a engañar a los lectores. En estos casos, es necesario corregir el registro e incluso solicitar su retractación”.

Estos problemas son más frecuentes de lo que cabría imaginarse. Un análisis manual llevado a cabo por la microbióloga Elisabeth Bik en 2016, escudriñó más de 20.000 artículos del área de la biomedicina y halló algún tipo de adulteración en el 4 % de ellos (lea en Pesquisa FAPESP, edición nº 310). Resulta sencillo descubrir las alteraciones groseras, pero hay casos de manipulaciones más sofisticadas cuya identificación puede llegar a ser bastante compleja. Uno de los principales retos actuales para los editores reside en reconocer los manuscritos producidos por las llamadas “fábricas de papers”, servicios ilegales que comercializan trabajos científicos por encargo, a menudo con información falsificada e hasta con imágenes fraguadas. Recientemente, Bik identificó 400 artículos con imágenes tan similares que sugerían un origen común: una fábrica de papers. En algunos casos había indicios de que se había utilizado una imagen modelo para representar diversos experimentos, adaptándola al contenido de cada documento fraudulento, por ejemplo, alterando el balance de colores o cambiando de lugar algún elemento.

Uno de los desafíos que plantea la detección de las manipulaciones en forma automática consiste en disponer de repositorios con grandes volúmenes de fotos, que sirvan como referencia para rastrear el origen de los contenidos reutilizados, así como bases de datos de manipulaciones frecuentes, que permitan detectar patrones de fraude en los manuscritos presentados para su publicación. En el análisis del texto de los artículos científicos, estos recursos ya se encuentran disponibles y abonan el funcionamiento de soluciones antiplagio. El ingeniero de la computación João Phillipe Cardenuto, quien está siendo dirigido por Rocha en su doctorado, publicó un artículo en la revista Science and Engineering Ethics en agosto del año pasado en el que reúne ejemplos de adulteraciones de imágenes y presenta una biblioteca de algoritmos, disponible en acceso abierto, que reproducen y son capaces de identificar duplicaciones, retoques y supresiones. Las imágenes disponibles en la biblioteca no son reales, sino reproducciones creadas para simular las características de las manipulaciones más habituales. Ello se debe a que no podían utilizarse las figuras fraudulentas obtenidas de estudios retractados por cuestiones legales y restricciones de derechos de autor.

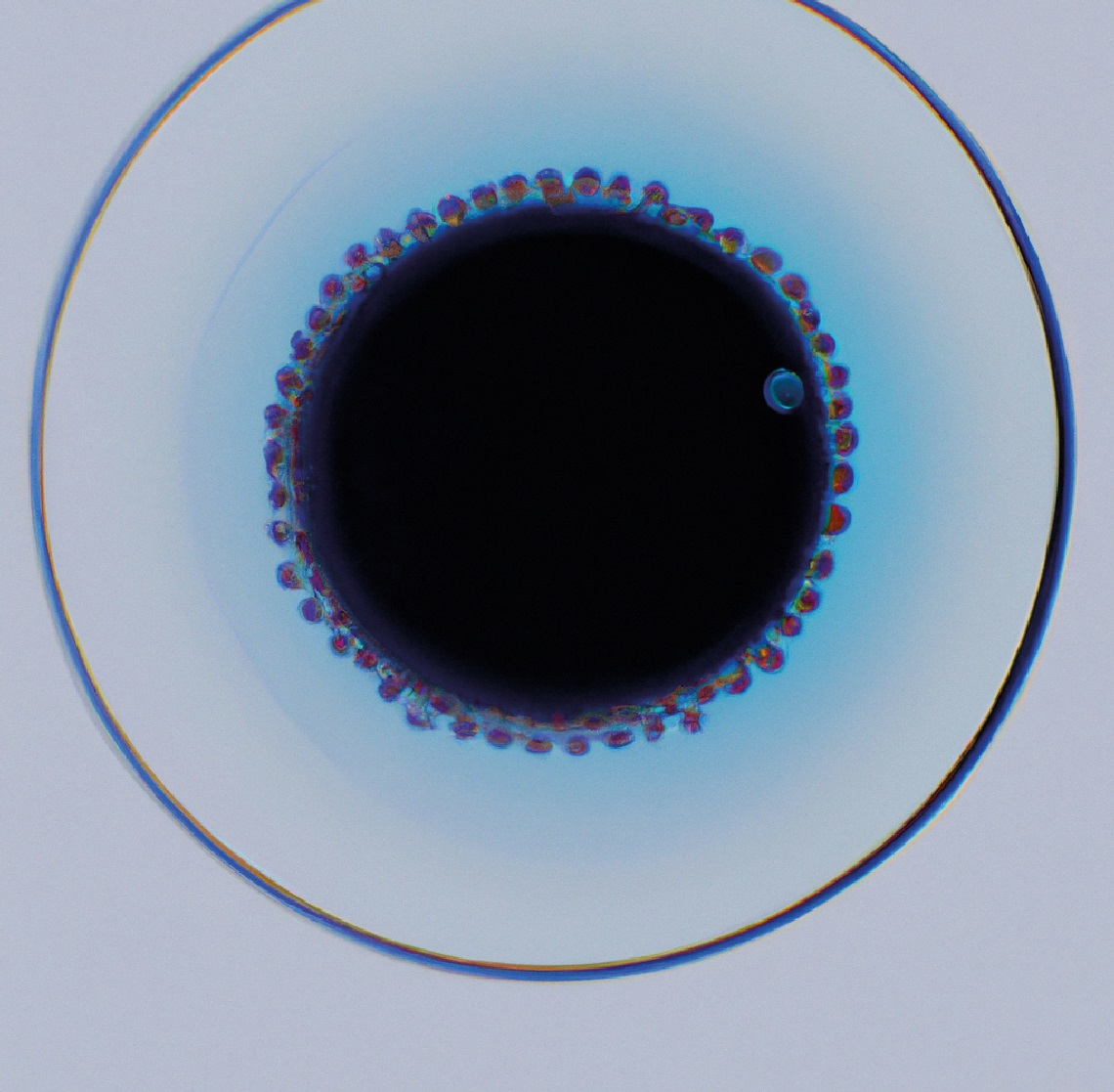

“Imagen manipulada de una célula, en estilo minimalista”, según la versión del software DALL-EDALL-E

Ahora Cardenuto está trabajando para identificar las características de las imágenes adulteradas en documentos generados por fábricas de papers, y en entrenar algoritmos para su rastreo en la literatura académica. Ya existen herramientas automáticas para detectar artículos de este tipo, como Papermill Alarm, un software desarrollado por Clear Skies, una empresa de servicios de datos académicos del Reino Unido. El programa utiliza técnicas de aprendizaje profundo (deep learning) para analizar títulos y resúmenes de manuscritos y comparar su lenguaje con el de otros trabajos conocidos elaborados por estos servicios ilegales. El software no indica que el manuscrito es fraguado, sino que apunta hacia aquellos que merecen una investigación más profunda antes de su publicación. “Como el contenido parece tener sentido, siempre quedan dudas de si realmente fueron fraguados. Si conseguimos reunir evidencias asociadas a imágenes, será más fácil tener la certeza”, dice Cardenuto.

El futuro tiende a ser aún más complejo. Una frontera tecnológica pasa por la generación de imágenes sintéticas, producidas por programas de inteligencia artificial. “Si ya es bastante difícil confirmar si una foto contiene elementos de otra, habrá que crear nuevos parámetros para comprobar fraudes en los registros que sean completamente fraguados”, dice Rocha. Aún no hay pruebas de que esto esté ocurriendo en trabajos académicos, pero la tecnología es una realidad palpable: programas como DALL-E 2, de OpenAI, son capaces de inventar imágenes sobre cualquier tema a partir de descripciones presentadas en formato de texto, como si se tratara de un retrato hablado. “La inteligencia artificial puede ayudar a detectar datos duplicados en investigaciones, pero también puede utilizarse para generar información falsa”, escribió Elisabeth Bik en un texto publicado en octubre en el periódico The New York Times. “Hoy en día es fácil producir fotos y videos fraguados de eventos que nunca ocurrieron y las imágenes generadas por inteligencia artificial ya pueden haber comenzado a envenenar la literatura científica. A medida que esta tecnología vaya desarrollándose, será mucho más difícil distinguir lo falso de lo real”.

No es imposible rastrear los artículos cuyos textos han sido generados por programas tales como los del linaje ChatGPT. “La ciencia forense tiene una premisa, según la cual, cualquier intervención deja algún vestigio”, dice Anderson Rocha. “Un algoritmo de inteligencia artificial sería capaz de identificar un paper generado por otro algoritmo semejante, pero probablemente necesitará que se lo perfeccione en forma continua para que esté a la par de la sofisticación creciente de las formas de adulteración. Será un juego del gato y el ratón para ver quién logra más avances: nosotros o los fraguadores”.

Proyectos

1. Déjà vu: coherencia temporal, espacial y de caracterización de datos heterogéneos para el análisis y la interpretación de la integridad (nº 17/12646-3); Modalidad Proyecto Temático; Investigador responsable Anderson Rocha; Inversión R$ 1.912.168,25.

2. Filtrado y análisis de procedencia (nº 20/02211-2); Modalidad Beca doctoral; Beneficiario João Phillipe Cardenuto; Investigador responsable Anderson Rocha; Inversión R$ 130.935,02.